HBM(Photo08)

HBMに関して言えば、もうコンシューマ向け機器では殆ど使われる事が無くなった。理由は主にコストである。そもそもHBM Memoryそのものが高価であり、加えて接続にはInterposerが必要である。最近はPackageの技術も進化しており、Radeon RX 7000シリーズのInfinity Cache/GDDR6 I/Fの様に、Silicon Interposerなしで同等以上の配線密度を実現している例もあるのだが、HBMはそもそもSilicon Interposerでの接続を前提に規格が策定されているので、どうしても余分にコストが掛かる。Intelの第2世代EMIBとかAMDのInstinct MI200シリーズの様に、部分的にInterposerを入れる形でコストを抑えた例も無くはないが、パッケージ基板に直結とは比較にならない。そういえばHBMの派生型で、Interposer無しでパッケージに直結できる低価格版の提案もあったが、結局賛同を集められなかったようで消えてしまった。

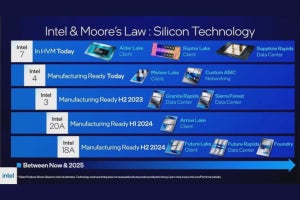

ただHBMの需要自体は別になくなっていない。主にデータセンター向けであるが、昨今ではSapphire RapidsベースのXeon MAXとかPonte VecchioがやはりCPUにHBMを集積しているし、NVIDIAのHopperとかAMDのInstinct MI200/MI300とか、新製品にも多く採用されている。AIプロセッサでも、特にTraining向けではHBMを使う例は少なくない。

さてそんなHBMであるが、既にHBM2eが量産製品に採用されており、これはもう普及に入ったフェーズ。これに続くものとしてHBM3があるが、こちらの標準化はJEDECで既に完了している。最大転送速度は6.4Gbps/pin、1024pinで1 Stackあたり819GB/secに達する。またHBM2では最大8 stackだったDRAMダイは、HBM3では16Stackになり(他に4/8/12 stackもサポート)、1ダイあたり最大32Gbitまでの容量をサポートしたことで、最大メモリ容量は16 stackで64GBに達している。SamsungはIceboltというブランド名で既に量産開始しており、SK HynixもHBM3の開発完了を2022年10月にアナウンスした。MicronはOfficialにはアナウンスが無いが、同社の1βnm DRAMをそのままHBM3に利用するものと思われる。

そんなわけで2023年には、このHBM3を採用した製品が市場に投入される(ただしサーバー向けもしくはAI Training向け)事になるかと思われる。既にRambusやSynopsysなど複数のベンダーがHBM PHY IPの提供を開始しており、しかも例えばRambusは8.4Gbps/pin、Synopsysは7.2Gbps/pinとHBM3の規定以上の速度に対応しているあたりは、あるいはHBM3eあるいはHBM3+といったものが出てくる可能性がある(Photo05でSamsungはHBM3Pが1TB/secとしており、7.8Gbps/pin程度の速度を想定している様に思える)。

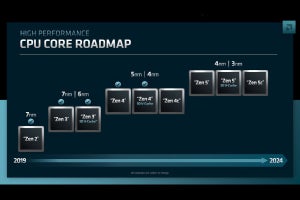

ちなみにその先についてだが、HBM4に向けてSamsungはやはり2022年のVLSI Symposiumで"A 68.7-fJ/b/mm 375-GB/s/mm Single-Ended PAM-4 Interface with Per-Pin Training Sequence for the Next-Generation HBM Controller"という論文を出しており、これはHBM4に向けた提案の一環と思われる。ただ先ほどのGDDR7の議論同様、これはあくまでも提案レベルの話であって、まだPAM-4で行くとJEDECのWorking Groupが決めた訳ではなく、現在も検討中である。多分2023年はHBM3+(or HBM3e/HBM3P)の標準化が行われるかどうか? というあたりで、HBM4は2024年以降(多分2025年かその辺)まで作業が掛かると思われる。

CXL Memory(Photo09)

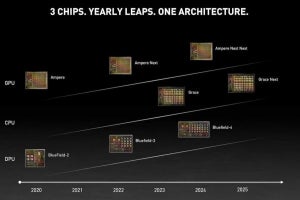

コンシューマ向けには一切関係ない(何しろプラットフォームがない)CXL Memoryだが、サーバー向けには着々と進んでいる。最初にこれをフルサポートする商用プラットフォームはGenoaことEPYC 9004シリーズであり、現在はプラットフォーム上でアプリケーションの開発とかOS/ミドルウェアの対応を行っている最中であるが、ぶっちゃけIntelのOptane Persistent Memoryに代わる新しいIn-Memory Computing Platformになり、しかもオープンスタンダードという事もあって、Micronの様に「3D XPointを捨ててCXLに注力する」とプレスリリースの中で明確に述べた企業もあるほどである。

比較的準備が早かったのはまたしてもSamsungで、2021年5月には早くも評価用のCXL Memory Moduleをリリース、同年10月にはSMDK(Scalable Memory Development Kit)の提供を開始し、2022年5月には512GB Memory Module製品まで発表している。このSamsungの512GB ModuleはPCIe Gen5 x8なので帯域そのものはModuleあたり16GB/secでしかない。速度としてはDDR5-4000相当という計算になる。ただ、例えばGenoaの2 Socket構成であれば、128本ないし160本のPCIe Laneが利用できる。このうち半分をStorage、半分をその他(Networkなど)に廻したと考えても、1台のサーバーにこの512GB Moduleを16本ないし20本搭載できる。トータルの帯域は512GB/secないし640GB/sec、CXLメモリ総容量は8TBないし10TBになる。これとは別にGenoaはプロセッサあたり6TB(2 DIMM/chの場合:1 DIMM/chだと3TB)のメモリを利用でき、こちらの合計帯域は460GB/secほど。つまりメインメモリよりも広い帯域と容量をCXL経由で実現できることになる。Optane Persistent Memoryだと最大で4.5TB/Socketのメモリ容量が利用できるという話だったが、これを遥かに上回る容量と帯域の構成が既に可能になる訳で、それはMicronならずともこのビジネスに参入したいと思うのは当然だろう。SK Hynixも2022年8月にCXL Memoryを発表しており、2023年に量産開始予定と述べている。Microchipも同じく2022年8月に、CXL Memory ControllerとしてSMC 2000シリーズを発表しており、これを利用してDRAMと組み合わせることで、DRAMベンダーでなくてもCXL Memoryを作ることも可能になっている。

現状はまだソフトウェア側の対応が十分とは言えないので、今年はまだ爆発的に売れるというところまでは行かないだろう。ただ2024年に向けて今年後半からは、各社からCXL Memoryが次第に出揃い始めると思われる。

ちなみにIntel、AMD共にCXL MemoryをConsumer向けCPUでサポートする計画は「無い」としており、残念ながら普通のユーザーには無縁である。どうしても使いたければ、Threadripper 7000シリーズとかXeon W-3400シリーズなどを導入する必要があるだろう。