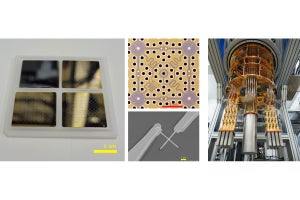

また、著作権侵害の問題に関しては、生成されたテキストに類似するテキストが学習データにないかを自動検索し、著作権侵害のチェックを容易にしているという。実際に自動検索ツールが生成されたテキストと類似する文章を学習データ中で見つけた場合、赤い点線の下線でそれを知らせ、該当する文をクリックすることで、検索結果を生成文の下に出力し、そのテキストが収集されたURLと共に確認できるようになっているとした。

-

1つ目、2つ目の出力は有用な情報の例。3つ目の出力も間違いではないが、自動検索システムにより、著作権侵害となる恐れがあることが一部に確認されたため(赤の点線の下線の行)、そのままの表示を避けてこのような表示があえてなされている。最下段のURLがあるが、それにより出典元のWebページを表示できる仕組みだ。(出所:NICT Webサイト)

今後、NICTでこれまでに人手により蓄積してきた大量の学習データを用いてファインチューニングなどを実施し、品質を高め、具体的なアプリケーションでの活用を容易にしていく予定とする。具体的には、NICTが2015年に試験公開を開始した、大規模なWebページを対象とする質問応答システム「WISDOM X」の150万件を超える質問応答用データなどの活用を検討しているという。

なお今回の成果は、400億パラメータという生成系の日本語大規模言語モデルを試作(事前学習)したものだが、事前学習に用いるテキストが十分であるとは考えていないといい、今後は学習用のテキストについて、日本語を中心としてさらに大規模化していくとのことだ。

また現在は、GPT-3と同規模の1790億パラメータのモデルの事前学習に取り組んでおり、適切な学習の設定などを探索していく予定としている。さらに、より大規模な事前学習用データ、大規模な言語モデルの構築に際し、前述したポジティブ・ネガティブ両方の要素に関して改善を図るとともに、WISDOM Xや、NICTがKDDI・NECソリューションイノベータ・日本総合研究所と共同開発した高齢者介護支援用対話システム「MICSUS」など、既存のアプリケーションやシステムの高度化などに取り組むことも計画しているという。

加えてNICTでは、まだ誰も考えておらず、Webなどにも書かれていない、具体的で“尖った”将来シナリオや仮説をテキストとして生成し、対話システムによるブレインストーミングなどで活用するための研究を実施してきたが、このような研究においても、今回開発された日本語大規模言語モデルなどを活用していくとする。さらに、民間企業・大学・国の研究機関などとの共同研究などを拡大し、安全に活用可能な大規模言語モデルの研究開発などに産官学で連携して取り組むとしている。