Binary Pixel

今回の発表の一番の肝とでも言うべきものが、「Binary Pixel」であった。端的に言えば、既存のCCD/CMOSセンサの仕組みをそのまま使いながら、ダイナミックレンジと感度を広げるための、新しいI/Fの仕組みとでも言うべきものである。まずWoo博士は既存のセンサの欠点を示した後(Photo26)、Binary Pixelではこれがどんな風に改善されるか、を説明した(Photo27)。具体的に、従来のCMOSセンサとBinary Pixelで条件を同じにして撮影した映像を比較したのがこちら(Photo28・29)である。

|

|

|

|

Photo28:左が従来のCMOSセンサで、外の明るさに引っ張られて室内がコントラスト強すぎになっている。Binary Pixelではダイナミックレンジが向上して、室内のディテールがちゃんと映し出されているのが判る |

Photo29:こちらもほぼ同様。通常はHDR撮影などで右側の映像を作り出すことになるが、Binary Pixelではその必要が無いとしている |

ではこれをどう実現したのか、の簡単な説明がPhoto30になる。一番左が、Binary Pixelの元になる"Binary Operation"の構造である。ちょっと通常のCCD/CMOSセンサに話を戻すと、これらのセンサは入射光に応じた形でセルに電荷が蓄積する。これを一定間隔で読み出す際にA/Dコンバータを使って電荷の量を測定することで、セル毎の光の強弱をデータの形で取り出すという仕組みである。これに対してBinary Pixelではあるしきい値(Threshold)を設け、この値以上か以下かの2値でデータを取り出す事になる。このあたりがBinaryの所以である。

ところがこのままだと明るさの区別が出来ないというか、明るいか暗いかしかないので、中間の強度が原理的に存在しない。で、これをどうするかといえば、各セルのスキャンの回数を猛烈に多くする、という形でカバーする。今までの方式であれば、たとえばシャッタースピードが1/100秒ならば10msの間露光を行い、その結果をまとめて取り込む事になる。これに対してBinary Pixelだと、各セルのスキャン回数がもっと猛烈に多い(具体的な数字は未公開だったが、普通に考えてもスキャン周期がmsということはありえず、μsec未満のオーダーだろう)。だから1/100秒のシャッタースピードだとすると、その間にたとえば10000回とかのスキャンを行なうことになる。このスキャンごとの結果を積算することで、結果として光の強度をもっと細かい精度で捕らえることができるという仕組みだ。

もう少し具体的な数字として後からWoo博士より開示された情報によれば、通常の携帯電話向けCMOSセンサの場合、FWC(Full Well Capacity:飽和容量。どれだけ電荷をセルに蓄えられるかを示す数)はセルあたりおおむね5,000光電子ほど。一眼レフカメラなどで使われる、大型のセンサで50,000光電子ほどになる。これに対し、Binay Pixelでは換算すると飽和容量が65,000~200,000光電子程度になるという。要するに光の強度が強い場合でも、セルが飽和する前に読み出してしまうので飽和しにくく、これが結果としてダイナミックレンジの拡大に繋がっているという話である。逆に言えば、現在の携帯電話向けCMOSセンサと同程度の感度でよければ、セルのサイズを25分の1まで縮小することが可能、という計算も可能になる。

またスキャン回数が猛烈に多ければ、空間的方向や時間方向でのオーバーサンプリングも容易であり、これにより画質の改善やダイナミックレンジの拡大も出来る、という話である。

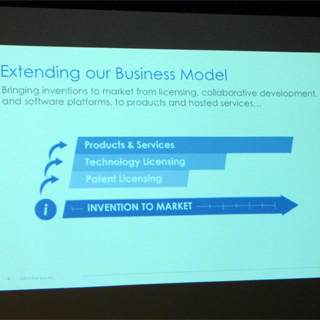

ここまででも割と凄いとは思うのだが、今回RAMBUSがさらに一歩進めたのはTest Chipの製造まで行なったこと(Photo31~33)。これに関しては、「Unity Semiconductorの買収によって、我々はこうしたデバイスの製造を行なう能力を得た」(Nadel氏)としている。もちろん、このTest ChipはあくまでProof-of-Conceptの目的であり、まだソフトウェアの準備なども整っていないからすぐに製品化に繋がるわけではないが、必要ならばRAMBUSが自社で製造・供給することも今では可能になっている。現在はまだTechnology Demoのレベルではあるが、このマーケットには手ごたえを感じているそうだ。