SC09では、約2万5,000m2の展示場に318のHPC関係の研究所やメーカーの展示ブースが並び、いみじくもゴア元副大統領が行った講演の中で、「ここは貴方がたにとってはディズニーランドのようなものでしょう」と指摘したように、興味深い新製品などが展示され、まさにHPC関係者にとってのディズニーランドとなっていた。

204マイルの光ファイバを敷設したSCiNet

SC09の展示会場には、例年通り、展示ブースの機器や会場の無線LANなどをサポートするSCiNetが設置された。今年は各社から寄付された2,000万ドル相当のルータやスイッチと合計204マイルの東京-名古屋間に相当する長さの光ファイバが張り巡らされ、会場の外へのバンド幅も400Gbpsと太い伝送路が用意された。

IBMはPOWER7モンスターを展示

今回のSC09にて展示された新製品の目玉は、IBMのPOWER7サーバである。このサーバは現在ハイエンドHPCシステムに用いられているPOWER 575の後継と考えられ、イリノイ大学のNCSAに設置される10PFlops級のスパコンであるBlueWatersに使用されると見られる。

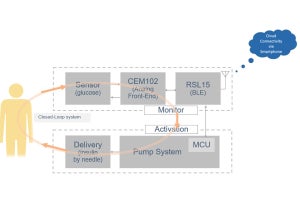

IBMがCEC(Central Electronics Complex)と呼ぶ2Uサーバは、この写真の手前が装置の前面で、一番手前のホースの接続されているのが水冷の電源である。角度が浅い写真でちょっと見難いが、奥行き方向にDIMM、CPUモジュール、DIMM、そしてインタコネクトモジュール、PCI-Expressカードと外部接続用コネクタ類の順に並んでいる。

この2Uサーバは、幅が約1m、奥行きが1.8mで、フル実装された場合の重量は約150Kgとのことで、とても1人では持ち上げることが出来ない重量である。

CPU MCMは4個のPOWER7チップを搭載し、クロックは3.5GHz~4GHzと書かれていたが、MCM全体では1TFlopsと書かれており、このサーバでは4GHzクロックで動かしていると考えられる。このクロックで8コアであるので、当然、消費電力は大きく、MCMあたり800Wと表示されていた。このMCMに銅パイプで接続された水冷のコールドプレートが押しつけられ800Wの熱を放熱している。

メモリはコントローラLSIを搭載した専用の大型DIMMで、通常のDIMMの4倍の容量があるという。これにW字型のヒートパイプが付けられたヒートスプレッダが取り付けられ、両側の水冷のレールにねじ止めされ、伝導でメモリモジュールを冷却している。

インターコネクト部のMCMは、スイッチチップは1個であるが、この写真ではチップが搭載されずパッドだけが並んでいるところにOE(Opt-Electronic)変換とEO変換を行うチップが搭載され、外部接続用のオレンジ色の光ファイバが引き出されている。写真に見られるように、このMCMは合計1.1TBpsのデータをスイッチする能力を持っている。このMCMも水冷されており、空気で冷やすのはPCIカードだけとなっている。

筺体は展示されなかったが、パネルによる説明があり、最下部に熱交換器、その上に、この2Uサーバが12台搭載され、その上の黒っぽい部分がローカルディスク、そして最上部に外部から供給される数百VのAC、もしくはDC電源をCECなどに供給する低圧DCに変換する電源ユニットが搭載されている。

この筺体全体の重量は約3tで、通常の19インチラックよりはかなり底面積は大きいものの、床の荷重が問題になるセンターも多いのではないかと思われる。