ついにOS Xにも登場した「音声入力」

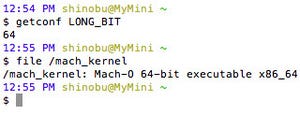

第3世代iPadで登場した「音声入力」は、iPhone 4S/iOS 5の「Siri」からアシスタント部分を省いた入力機能。原則としてシステム内部を見ることはできない(脱獄という手段はあるが)iOSでは、どのように稼働しているか確認できなかったが、OS Xならばそのあたりの自由が利く。

結論からいうと、音声入力の機構は「ことえり」などのインプットメソッドと同じだ。起動用のキーは別にアサインされているが(初期値では[Fn]の2回押し)、プログラムは他のインプットメソッドと同じ/System/Library/Input Methodsディレクトリにある「DictationIM.app」であり、Tiger以降のシステムでIME開発に必須のフレームワーク「InputMethodKit」もリンクされている。

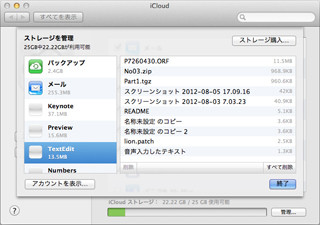

他のインプットメソッドと動作機構が同じということは、IME経由での文字入力が可能なアプリケーションすべてで利用できることを意味する。だからSafariや「メール」はもちろんのこと、ExcelやWordでも音声入力できる。さすがに「通知センター」から行うツイートを音声入力で行うのは不思議な感じだが、キーボードベースのIMEと同列に扱うということからは、Appleの音声入力に対する考え方が透けて見える。

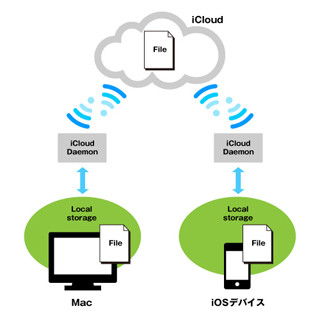

さらに調べてみると、クラウドとのデータのやり取りは「AssistantServices」というプライベートフレームワーク(技術仕様が非公開のAPI)が担っていることがわかる。このフレームワークは、iOS 5のSiri/音声入力で使用されているものと同名であり、そのノウハウがOS Xに持ち込まれたと考えてよさそうだ。

そのためか、変換精度はiOSの音声入力とほぼ同じ。主要部分はプライベートフレームワークであり、内部のしくみは想像するしかないが、"OS XとiOSの融合"がもっとも進んだ機能のひとつであることは確かだろう。

| 次ページ:着々と進む「サンドボックス化」 |