今回は、ポルノの話を。といっても世間一般に想起されるアレではなくて、RQ-1プレデター(当時。現在はMQ-1)から送られてくる動画の実況中継を見て軍幹部や政府高官が夢中になった、「プレッド・ポルノ」の方である。プレッドとはプレデターのことだ。

静止画から動画へ

銀塩の時代でも、動画の撮影はできた。これはフィルム式の映画のことで、映画館で上映するものだけでなく、個人で使用できる小さなカメラ(いわゆる8mmフィルム)や映写機もあった。ただ、スチール写真と比べると、使用している人は少なかったように思う。

偵察機の場合、銀塩でも枚数の桁が違う。われわれが使用している35mm版のフィルムカメラは36枚撮りのフィルムが上限だが、それでは写真偵察機だと少なすぎる。1度のフライトで数百枚、あるいは千枚単位の撮影を行っている。当然、フィルムのロールが大きくなって、かさばる。

スチールでもそんな調子だから、映画用のカメラを機上に積み込んで、現地の上空で動画を撮るなんてことは、少なくとも日常的ではなかったし、現実的でもない。しかも、大量のフィルムを持ち帰ってきて現像して、それを一コマずつ調べて有意な情報を拾い出す。なんてことを考えただけでも気が遠くなる。

しかし、デジタル化すれば状況が変わる。もちろん、データ量が増えればストレージ・デバイスは大型化するが、フィルムの分量と比べれば桁違いに小さい。もともとデジタル・データになっているものだから、それを無線で送ることもできる。

ただしそこで、無線通信につきものの制約が登場する。遠距離通信を可能にするには低い周波数の電波が必要だが、それでは伝送能力が足りない。高解像度のデータを送信するには高い周波数の電波が必要だが、それでは見通し線圏内の通信しかできない。静止画でもデータ量は少なくないのだから、動画ならなおのこと。

だから、RQ-1プレデターの前身であるUAV・ナット750で動画のリアルタイム実況を開始した当初は、水平線以遠まで進出できるようにするため、UAVと基地の間に中継機を飛ばした。プレデターから送られてきた無線を中継機が受信して、改めて地上の基地に向けて再送信する仕掛けだが、いささか面倒すぎる。

せっかく偵察用の資産が無人になっても、中継機が有人では人手がかかる。それに、有人の中継機は無人の偵察機ほど長く飛んでいられないから、交替が必要になってしまう。そこで、Kuバンドの衛星通信を使用することで解決した。衛星通信なら、赤道上にいる通信衛星を捕捉できる場所であれば、どこからでもデータを送れる。

RQ-1/MQ-1プレデターにしろ、改良型のMQ-9リーパーにしろ、あるいはRQ-4グローバルホークにしろ、機首がこんもり盛り上がっている。これは、その中に衛星通信用のパラボラ・アンテナが入っていて、かつ、衛星にアンテナを指向できるようにアンテナが首を振れるスペースを確保しているため。

このおかげで、中東を飛行しているプレデターやリーパーからの動画実況中継を、アメリカ本土に居ながらにして見られるようになった。かつては、夢物語だったような話が現実になったのだから、軍の幹部や政府高官が夢中になったのも無理はない。

動画実況は低速のプラットフォームに限られる

ただ、電子光学センサーで撮影した動画による実況中継ができるのは、無人偵察機や、せいぜいヘリコプターに限られる。つまり、あまり速度が速くなくて、現場上空で長時間の連続滞空が可能なプラットフォームである。

ヘリコプターの事例を見ると、例えばMH-60Rオーシャンホークは機首に電子光学センサーのターレットを積んでおり、さらにL3ハリス社製のKuバンド データリンク・HawkLinkを備えている。これは伝送速度10Mbpsを発揮するCDL(Common Data Link)で、センサーが捕捉したISR関連データを無線で送るために使用する。

HawkLinkの通信可能距離は最大100nm(185km)を超えるというが、Kuバンドでは見通し線圏内の通信しかできないから、ヘリの高度が下がれば通信可能な距離は短くなるはず。また、MH-60Rは有人のヘリコプターだから、無人機みたいに10時間も20時間も連続して飛ぶことはできない。

戦闘機はどうか。前回に書いたNTISR(Non-Traditional Intelligence, Surveillance and Reconnaissance)の絡みがあるので、ターゲティング・ポッドにデータリンク機能を付加すれば、理屈の上では動画による実況中継が実現可能。

ただし、ターゲティング・ポッドに衛星通信用のパラボラ・アンテナを組み込んで、かつ首を振れるようにするスペースをとるのは無理な相談。第一、ターゲティング・ポッドは胴体や主翼の下面に搭載するから、頭上にいる衛星を見通すのは難しい。

すると、見通し線圏内でしか使えないデータリンクにならざるを得ないと思われる。それでは用途は限られるし、地球の裏側から本土に向けて実況というわけにも行かない。それに、戦闘機は足が速いから現場上空をあっという間に通り過ぎてしまい、動画による実況中継はやりづらい。

動画が増えたらデータの山

個人レベルでも容易に理解できる話だが、静止画と比べると動画のデータ量は桁違いに多い。しかも、軍用のISR用途だと、ただ動画を流していれば良いというものではない。動画の内容を見て、分析して、そこから有用な情報を拾い出さなければ意味がなくなる。

それを人手でやるのは大変だ。動画の中から重要な情報を拾い出すのも、過去と最新の動画を見比べて違いを見つけるのも、手間がかかる上に熟練が求められる。おまけにデータ量は増える一方。「とにかく無人偵察機を飛ばして動画を録っておけ」と命令するだけなら簡単だが、それで積み上がった膨大なデータの活用はどうするか。

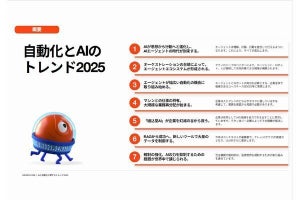

そこで、コンピュータにデータを食わせて自動解析させてはどうか、という話になるのは当然の帰結。折から、人工知能だの深層学習だのといった話が賑やかだから、これらは静止画の解析だけでなく動画の解析にも応用できるかもしれない。

著者プロフィール

井上孝司

鉄道・航空といった各種交通機関や軍事分野で、技術分野を中心とする著述活動を展開中のテクニカルライター。

マイクロソフト株式会社を経て1999年春に独立。『戦うコンピュータ(V)3』(潮書房光人社)のように情報通信技術を切口にする展開に加えて、さまざまな分野の記事を手掛ける。マイナビニュースに加えて『軍事研究』『丸』『Jwings』『航空ファン』『世界の艦船』『新幹線EX』などにも寄稿している。