自撮り写真をSNSに投稿する時に、「どこで撮りました」と説明をつけることもあれば、つけないこともある。ときには、わざと説明を省略して「どこで撮ったのか当ててみて」ということもありそうだ。

背景を参考にして場所を当てる

そんな時に着目したいのは、背景にある建物、施設、さまざまな風景といったもの。

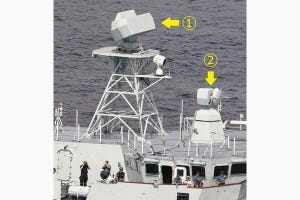

一例として、列車の中で撮った写真を挙げてみよう。車内の設備やその形状、座席の表面に張られたモケットの模様、そして窓の外に見える景色といった情報を子細に見ていくことで、いろいろな情報が意外とわかる。実際、それによって乗っている列車の号車まで特定された事例がある。

空港あるいは飛行機の機内で撮影した写真にも、同じことが言える。これまた、写真を1枚投稿しただけでフライトを特定された事例がある。

これを軍事情報分析の世界に応用するとどうなるか。

例えば、テロ組織の首領がどこかの山中で演説をして、その模様をYouTubeか何かに投稿したとする。普通なら「ふーん」で終わってしまいそうな話だが、そのテロ組織の首領を追っている軍や治安組織や諜報機関の関係者にしてみれば、話は別。問題の動画を子細に調べて、何とかして所在をつかむ手がかりが得られないか、と考えるだろう。

これが、周囲に何もない、真っ平らな砂漠のただ中であれば、場所の特定は難しい。しかし、山岳地帯で撮られた映像であれば事情は異なる。背景に映っている山がどこの山かを突き止めることで、現場を特定できる可能性があるからだ。山によっては形に特徴があることもあるから、そうなれば特定はしやすくなる。

山や湖や海は自然のものだが、もちろん建物をはじめとする人工物だって手がかりになり得る。極端な例を挙げれば、東京タワーが背景に映っていれば一目瞭然だ。似たような電波塔としては名古屋のテレビ塔や札幌のテレビ塔もあるが、形も高さも違うから識別はしやすい。

また、晴天・屋外の撮影であれば、影も手がかりになり得る。太陽は東から昇って南を回り、西に沈む。その前提があれば、順光になっているか、逆光になっているかで、撮影者と被写体の位置関係を推察できる。また、影がどちら向きに落ちているかで、午前中か午後かの区別もできるだろう。

さらに、その影の長さは季節によって変動する。同じ場所の同じ時間でも、夏場には太陽の位置が高くて影が短くなる一方で、冬場になると太陽の位置が低くて影が長く伸びる、なんていうことが起きる。鉄道写真を撮影している人なら、冬場に長く伸びる建物などの影に悩まされた経験がおありだろう。

ということは、その影を作っている物体の高さがわかっていれば、太陽光の入射角を計算できる可能性が出てくる。そのデータを太陽の動きに関する既知のデータと突き合わせれば、撮影日時まで突き止められるかもしれない(?)

さらに欲張るならば、地質や植生に関する情報も加えたい。例えば、一言で「砂漠」といっても、本当に砂で埋もれている砂漠があれば、岩石砂漠もある。砂にしろ岩石にしろ種類はいろいろあるから、場所によって色などが違う。

植生についても、モノによっては「この植物はこの地域にしか生えていない」「この樹木はこういう気候のところにしかない」といった特徴があるかもしれない。そういう、何か特徴があるモノが映っていれば、それも手がかりになり得る。

撮影時の天候も同様。極端に晴天率が高い場所で撮影されたと思われる映像なのに雨が降っていたら、現場と思われる場所の気象データと突き合わせることで、撮影日時を突き止められるかもしれない。

なんだか「かもしれない」ばかり列挙してしまったが、断言してしまっていいものかどうか判断をつけかねたので、つい慎重な書き方になってしまった。そこは御容赦いただきたく。

GEOINTの幅の広さと難しさ

このように、静止画あるいは動画ひとつとっても、そこからさまざまな情報を読み取れる可能性があるのだが、そこには大事な前提条件が1つある。それは何か。

先に挙げた例を見ると、「地形」「人工物」「太陽の動き」など、事前にデータを収集・蓄積しておかなければならない参照先ばかりなのである。何のデータの蓄積もない状態で、いきなり「テロ組織の首領がしゃべっている動画」だけ見せられても、おそらくは手も足も出ない。出るのはため息だけである。

映っているモノやその背景に基づいて、場所や日時を推測するには、基礎データを平素から集めて、いつでもパッと引き出せるようにしておかなければならない。パッと引き出せないところに埋もれているデータは、存在しないも同然である。

理想をいえば、コンピュータに基礎データを大量に蓄積しておいて、解析したい静止画や動画を読み取らせるだけで、その先はコンピュータが自動的に処理して「撮影場所は○○、撮影日時は△△頃と思われます」と答えを返してくれるのがいちばん楽だ。

しかし、それをやるには基礎データを集めて、コンピュータが検索・参照できる形にするだけでなく、ソフトウェアが「被写体」と「背景」を区別する仕組みも必要になる。こうやって書いてみると、これは正にディープラーニングの世界ではないだろうか。

もちろん、情報機関に所属する(たぶん)優秀な画像解析担当者が、自分の眼と頭を使って調べ上げる、という形はなくならないだろう。しかし、調べる対象が増えれば、人手では処理しきれなくなる。できればコンピュータで篩にかけて、「これぞ」というデータだけを人間の手で詳細にチェックするようにしたい。

たぶん、情報機関の関係者が考えていることも似たようなものだろうから、「映像を食わせてみて、事前に集めたデータと照合して撮影場所や撮影日時を推測するプログラム」なんていうものを開発していたり、あるいはすでに稼働していたりしても、筆者はまるで驚かない。さて、実際にはどうなっているだろうか。

著者プロフィール

井上孝司

鉄道・航空といった各種交通機関や軍事分野で、技術分野を中心とする著述活動を展開中のテクニカルライター。

マイクロソフト株式会社を経て1999年春に独立。『戦うコンピュータ(V)3』(潮書房光人社)のように情報通信技術を切口にする展開に加えて、さまざまな分野の記事を手掛ける。マイナビニュースに加えて『軍事研究』『丸』『Jwings』『航空ファン』『世界の艦船』『新幹線EX』などにも寄稿している。