従来のデータ統合では、リアルタイムの処理ができない

企業は競争力を維持するために、データを用いて豊富な情報に基づく意思決定を迅速に行えるようになる必要があります。Amazon、Netflix、Coca Colaなどのトップブランドは、高度なデータ分析によって、顧客の獲得や維持といった複雑なビジネス上の問題を解決し、顧客の購買パターンに基づく個別のロイヤルティプログラムの作成、リスクの識別、スコアリング、管理を行っています。

ただ、こうした分析を実現するには、最終的に分析モデルで使われることになる適切なデータセットを最初に特定する必要があります。データは石油と同じように、最初は未加工の状態であり、さらに活用できるようになるまでに、何段階ものクレンジングプロセスを経ます。

最終的にデータが利用可能になる前に、適切なデータを見つけ、クレンジングし、適切な形式に変換するという初期段階を踏むわけですが、この部分がこのプロセスの中でおそらく最も厄介です。調査によると、データサイエンティストの多くは、プロジェクトにかける時間のおよそ80%をこの種のタスクに費やしています。

しかし、組織が検討する必要があるのはこの問題だけではありません。今日、エンタープライズデータの量は毎年ほぼ 50%の割合で増大しています。このデータの 80%以上が非構造化データであり、リレーショナルデータベースやデータウェアハウスといった従来型のデータストレージソリューションでは歯が立ちません。組織がクラウドインフラストラクチャやデータレイクへの移行を進めるのはこのためです。

かたや企業の経営トップが必要とするビジネスレポートでは、自社のデータの幅広い統一的な分析が求められます。おそらく、こうしたレポートでは、データベース、データレイク、レガシーシステム内のデータ、クラウド内のデータなど、複数の異種システムからデータを抽出することになります。

ただし、レポートの精度を確保するには、オンプレミスおよびレガシーシステムを含むすべての異種システムを最新データと同期させる必要があり、このことがさらに難度を上げています。俊敏性の向上や市場投入時間の短縮のために、企業はリアルタイムあるいは、ほぼリアルタイムにデータにアクセスできるようになる必要もあります。つまり、適切なタイプのデータが必要なだけでなく、そのデータを適切なタイミングで入手できるようにする必要があるのです。

こうして、組織はこの統一化された分析を実現するために、さまざまなデータ統合手法を使用していますが、従来のデータ統合手法では、リソースを大量消費し、時間を浪費し、コスト高であることが実証されています。同様に、ビッグデータ分析や機械学習などのイニシアチブも複数の主要なソースからのデータがほぼリアルタイムで統合されたソースとしてまとめられるまで前進できません。

データ活用のためのデータ分析における課題がここにあります。

ビジネスインテリジェンスの歴史と論理アーキテクチャの必要性

さて、データ分析は、ビジネス上の意思決定のために有益な情報を見出すための、データをクレンジング、変換、モデリングするプロセスですが、この分析方式はごく最近のものです。

1980年代のデータ分析は、それほど多くの手順で構成されていませんでした。組織のデータアーキテクチャは、運用システムとその特定のシステムに接続されたキューブによって構成されていました。こうしたキューブは、基本的な種類のビジネスインテリジェンスを提供していましたが、この方式のビジネスインテリジェンスは、クロスアプリケーション分析をサポートしていませんでした。

つまり、複数の運用システムに存在するデータを分析する方法がなかったため、データの一貫性がなかったのです。その後、80年代後半に、ビジネスインテリジェンス・プラットフォームとしてのデータウェアハウス(DWH)という概念が導入されました。1 つのDWHが、すべてのエンタープライズデータのための単一のリポジトリの役目を果たすようになり、すべてのビジネスレポート用の単一のソースとして機能するようになったのです。

2000年代にビッグデータの時代が到来するまで、このやり方で問題ありませんでした。しかしビッグデータの到来により、データはリレーショナルデータベース内に存在する構造化データに限定されず、非構造化および半構造化形式のデータが含まれるようになりました。非構造化データや半構造化データには、これまでとは異なるストレージソリューションと、まったく新しい分析手法が必要です。

データの多様性と量の増大という形で表れたこの新しい課題は、データレイクと呼ばれる新しいタイプのストレージリポジトリの開発に影響を与えました。大企業は、DWHとデータレイクの両方をストレージと分析に使い始めましたが、データが複数のリポジトリ間で再び分割されるようになり、分析が断片化されるという問題に再び直面することになりました。加えて、これらの大規模な物理リポジトリを維持するには、かなりのコストが伴いました。

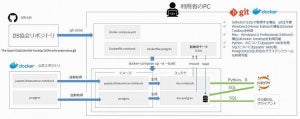

このタイプのアーキテクチャには、スケーラビリティ、データレイテンシ、およびコストの点で制限がありました。そこで論理データウェアハウスが登場したのです。論理DWHを使用することで、1 つの仮想レイヤーを介して業務アプリケーションが複数のデータソースに接続されるようになり、データ複製の必要なく、エンタープライズデータの統合分析を実現させることができたのです。

次回は、論理DWHを実現するテクノロジーの1つである「データ仮想化」について説明します。

著者プロフィール

Denodo Technologies 最高マーケティング責任者 Ravi Shankar(ラヴィ・シャンカール)

製品マーケティング、需要創出、コミュニケーション、パートナーマーケティングを含むDenodoのグローバルマーケティング活動の責任者。カリフォルニア大学バークレー校のハースビジネススクールでMBAを取得した後、OracleやInformaticaなどのエンタープライズソフトウェアリーダーから、25年を超えるマーケティングリーダーシップの実績を持っている。