生成AI(Generative AI)の世界が活気づいている。なかでも、進化が著しいのがLLM(Large Language Models、大規模言語モデル)だ。LLMは、高度な自然言語処理(Natural language processing)を行うために設計された機械学習モデルであり、大量のテキストデータを学習することで、より自然な文章の生成や文脈を理解した応答などを実現する。コンテンツ生成はもちろん、カスタマーサポートや教育など、さまざまな分野での応用が考えられるため、多くの企業が期待を寄せている。

本稿では、LLMの基礎から代表的なモデルの仕組み、活用事例まで、幅広く解説を行う。LLMへの理解を深めることで、業務効率化や新しい価値創造のヒントをつかんでいただきたい。

LLM&生成AI関連の注目ホワイトペーパー

オンプレミスで実現するLLM推論の優位性に迫る。パブリッククラウドよりコストパフォーマンスが75%向上冊子「生成AI最前線 ついに始まるLLMのビジネス活用」を無料提供! AI研究家カナコさんが解説

LLMを身の回りの業務に置き換えることは可能なのか? ビジネスとのシームレスな統合を目指すには

生成AIと大規模言語モデルは将来のビジネスにどのような影響を及ぼすのか?

LLMとは

LLMとは、膨大な量のテキストデータを学習し、自然言語を高度に理解して文章を生成するAI技術である。LLMの主な目的は、文章の文脈を深く理解し、適切な応答や要約を生成することだ。LLMを活用することにより、ユーザーは質問に対する最適な回答を得たり、高度な文章を生成したりすることが可能となる。

LLMはトランスフォーマーモデルを基盤としており、具体的なモデルとしてはBERT(Bidirectional Encoder Representations from Transformers)やGPT(Generative Pre-trained Transformer)シリーズなどが挙げられる。これらのLLMは、大量のデータセットを用いて学習することで、高い精度での自然言語処理を可能にしている。

企業では、LLMを活用することでさまざまな業務効率化や新しいサービスの創出が進んでいる。例えば、カスタマーサポートにおける自動応答系統の開発や、マーケティングに用いるコンテンツの自動生成など、多岐にわたる活用が始まっているのだ。

LLMは現代のAI技術を語る上で重要な要素の1つであり、今後も進化を続ける技術であると言える。

LLMと生成AIの違い

LLMと生成AIは、混同して語られがちだが、両者には明確な違いが存在する。LLMは、自然言語処理を高精度に行うための技術であり、大量のテキストデータを学習して文脈理解や言語生成を行うものである。ChatGPTやGeminiなどが代表例であり、特定の文脈に適応して高精度な回答を提供することができる。

一方、生成AIは新しいコンテンツを生成する能力を持つAI技術だ。テキスト生成だけでなく、画像生成のほか、音声生成などが可能となっており、特にクリエイティブ領域での応用が進んでいる。

技術的な違い

生成AIは、新しいコンテンツやデータを生成することを主目的としている。画像生成やテキスト生成、音声生成など多岐にわたる用途で利用され、ディープラーニング技術を駆使してパターンや特徴を学習し、新たなデータをつくり出す。そのプロセスで利用される技術には、GAN(Generative Adversarial Networks、生成敵対ネットワーク)やVAE(Variational Autoencoder、変分オートエンコーダ)などがある。

生成AIの中でも、自然言語処理の分野に特化している技術がLLMだ。LLMは、膨大なテキストデータを学習して自然言語の文脈を理解し、その理解に基づいた適切な応答を生成する。生成は、トークン化、エンコード、デコードなどのプロセスを通じて行われる。具体例として、先にも挙げたBERTやGPTなどのモデルが存在する。

LLMを含む生成AIは、ディープラーニング(深層学習)の技術を基盤としているが、単に「生成AI」と言った場合、画像や映像、音声、テキストなど、さまざまなデータ形式を生成するAIを総称しているのに対し、「LLM」はテキストの理解と生成に特化したものであることに留意したい。

機械学習との違い

機械学習は、データからパターンを学び、それを基に予測や分類を行う技術であり、一般的には回帰分析やクラスタリングなどが含まれる。 一方、LLMは膨大なテキストデータを学習し、自然言語を高度に理解し生成することに特化している。

また、機械学習モデルは明示的なルールや手本に基づき学習と予測を行うことが多いが、LLMは、文脈の意味を捉え、そのうえで新しいテキストデータを創り出す。この違いは、応用範囲の広さと複雑性、そして処理の正確性に大きな影響を及ぼす。

以上の点から、LLMを含む生成AIは、従来の機械学習技術を大きく進化させたものだと言える。

LLMの仕組み

LLMの仕組みは、主にトークン化、エンコード、文脈理解、デコード、および確率出力の5つのステップで構成される。

まず、トークン化とは、テキストを単語やサブワードなどの小さな単位に分割するプロセスである。例えば、元のテキストが「I am a boy.」ならば、「I」「am」「a」「boy」「.」に分けるといった具合だ。この段階で、モデルは文脈を理解するための基本的な単位を取得する。

エンコードのステップでは、トークン化された単位が数値データに変換される。これにより、テキストをモデル内部で処理しやすくなる。エンコーダーは、文脈を考慮しながら各トークンの意味を理解し、それを高次元のベクトル表現として出力する。このプロセスにより、モデルは文脈間の関係性を捉えられるようになる。

次のデコードとは、エンコードされた情報を元に戻す復号のプロセスである。デコーダーは、文脈を基に次に来るべきトークンを予測し、それを文章として生成する。最後に、確率出力では、次に来るトークンがどの単語になるべきかを確率的に判断する。この判断はモデルが学習したデータに基づき行われる。

これらのプロセスを通じて、LLMは高精度な自然言語処理を実現する。ではそれぞれのステップを詳しく見ていこう。

トークン化とエンコード

LLMがまず行うのが、トークン化だ。トークン化とは、テキストを小さな単位に分割するプロセスであり、これによりモデルは自然言語を理解しやすくなる。日本語の例で考えてみよう。「今日は良い天気です」という文をトークン化すると、「今日」、「は」、「良い」、「天気」、「です」といった単語や句などに分割される。

次のステップであるエンコードとは、トークン化されたテキストを数値データに変換するプロセスを指す。LLMは数値データを入力として処理するため、この変換が必要となる。例えば、各単語に一意のIDを付与し、「今日」はID1、「は」はID2などとする。この数値データを用いて、モデルは文の意味や文脈を理解し、適切な応答や生成を行うことができる。

トークン化とエンコードは、LLMの精度と効率を大きく左右する。適切なトークン化とエンコードを行うことで、モデルの性能を最大限に引き出し、高精度な自然言語処理が実現できるのだ。

文脈理解とデコード、確率出力

その後行われるのが、文脈理解とデコードである。文脈理解とは、言語の中で単語やフレーズが使用される環境(文脈)を深く解析し、それに基づいて意味を捉えるプロセスである。このプロセスを経ることで、LLMはより正確な意味を抽出できるようになる。

次のデコードとは、エンコードされた入力データを基に、それを人間が理解できる自然な形式に再構築するプロセスである。

最後に、生成された単語や文章の出現確率を計算し、出現確率の高い単語や文章を出力する。

このようなプロセスにより、文脈を理解した適切な言語生成が行われる。

代表的なLLMの種類

現代のAI技術において代表的なLLMとして知られるモデルには、BERT、GPTシリーズ、LaMDA、Claudeなどがある。これらのモデルは、それぞれ独自の特性や強みを持ち、さまざまな用途に応じて活用されている。

以下でその詳細を解説しよう。

BERT

BERTは、Googleの研究者が開発した大規模言語モデルである。BERTは、双方向のトランスフォーマーアーキテクチャを採用している点が特長だ。

従来のモデルは単方向(順方向または逆方向)に文を読み取っていたが、BERTは文を前後から同時に読むことにより、より精緻な文脈理解を可能にする。この特性により、自然言語処理タスクにおいて高い精度を発揮する。

そのため、BERTは質問応答や感情分析、翻訳などのタスクにおいて優れた性能を発揮するとされており、特に検索エンジンの改善やカスタマーサポートの自動化など、ビジネス向けの利用が広がっている。

GPTシリーズ

GPTシリーズは、OpenAIによって開発されたLLMの1つである。GPTは「Generative Pre-trained Transformer」の略であり、その名前が示す通り、生成系のAIとしての能力に焦点を当てている。このモデルの特長は、大量のテキストデータを事前に学習することで、新しいコンテンツを生成する際に優れた文脈理解と自然な文章生成を行う点にある。

特に注目を集めているGPT-3は、1750億のパラメータを持つことで、非常に高い精度のコンテンツ生成が可能である。GPT-3の登場により、自然言語処理の応用範囲は大幅に拡大し、ビジネスにおいても顧客問い合わせの自動応答やマーケティング資料の自動生成など、多岐にわたる活用例が増え始めている。

GPTシリーズの技術的な強みは、トランスフォーマーアーキテクチャを活用し、「アテンションメカニズム」を用いてエンコードとデコードのプロセスを効率的に行う点だ。アテンションメカニズムでは、入力されたデータにおいて「注目すべき重要な部分」を判断して処理を行う。その結果、高度なテキスト解析・生成を実現するのである。

LaMDA

LaMDA(Language Model for Dialogue Applications)は、Googleが開発したLLMである。LaMDAは特に自然な対話文を生成することに重点を置き、ユーザーとの流暢で有意義な会話を実現することを目指している。従来の言語モデルに比べ、LaMDAはユーザーの意図や文脈を深く理解することができ、より人間らしい応答を提供できるという点が強みだとされている。

LaMDAの開発には大量のテキストデータが使用されており、トレーニングを通じて多様な話題に対応することが可能になっているという。特定の専門知識を必要とする質問にもある程度の精度をもって答えることができるため、ビジネスや教育、エンターテイメントなどさまざまな分野での応用が期待できる。

Claude

ClaudeはAnthropic社が開発した大規模言語モデルである。このモデルは、安全性と倫理的側面を重視して設計されており、自然言語処理を行う際に非常に高い信頼性を持っている ことが特長的だと言われている。

Claudeはさまざまな高度なタスクに対応する能力を有しており、特にビジネスシーンで役立つことが期待される。例えば、企業内の知識管理やカスタマーサポートにおいて、ユーザーからの問い合わせに迅速かつ正確に応答しなければならない場合などに、威力を発揮するのではないだろうか。

他のLLMと比較して、Claudeは特定のバイアスを持つデータに対する適応能力も高いとされている。そのため、偏りのない公平な情報提供が強く求められる場面においては特に有用だろう。

LLM&生成AI関連の注目ホワイトペーパー

オンプレミスで実現するLLM推論の優位性に迫る。パブリッククラウドよりコストパフォーマンスが75%向上冊子「生成AI最前線 ついに始まるLLMのビジネス活用」を無料提供! AI研究家カナコさんが解説

LLMを身の回りの業務に置き換えることは可能なのか? ビジネスとのシームレスな統合を目指すには

生成AIと大規模言語モデルは将来のビジネスにどのような影響を及ぼすのか?

LLMの活用事例

LLMの活用事例については、さまざまな分野において具体的な応用が進んでいる。その一例として、カスタマーサポート業務が挙げられる。大規模言語モデルを用いることで、顧客の問い合わせに対して迅速かつ適切な回答を生成し、業務効率の向上を図ろうというわけだ。また、FAQを自動生成することで、顧客対応の効率化やFAQの品質向上も期待できる。

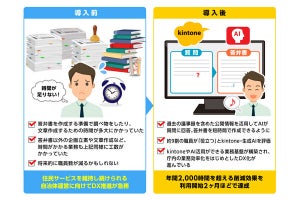

ソニーネットワークコミュニケーションズの場合

自社で提供する「NURO 光 メッセージサポート」に、生成AIによる顧客応対を導入したソニーネットワークコミュニケーションズ。従来のAIによるカスタマーサポートは、企業側が想定した質問やそれに類似した質問への回答に限られていた。しかし、LLMの登場により、どのような質問にも、何かしらの回答をすることが可能になった。もちろん、何を回答しても良い訳ではない。そこで同社はRAG(Retrieval-Augmented Generation、検索拡張生成)の技術と組み合わせた活用を考えたという。RAGを取り入れたことで、カスタマーサポートの精度は大幅に向上、導入後は問題を即時解決する確率が3割から8割に改善されているそうだ。

【詳しくはこちら】生成AIで進化するカスタマーサポート - ソニーネットワークコミュニケーションズはRAGと何を組み合わせたか?

その他のLLMの活用事例に関するトピック

導入時の課題と解決策

LLMの導入に際して、いくつかの課題が浮き彫りになっている。まず挙げられるのは、モデルの偏り(バイアス)の問題である。LLMはトレーニングデータに依存し、そのデータにバイアスが含まれていると、生成される出力も偏ったものになる可能性がある。これに対する解決策としては、多様なデータセットを使用し、バイアスを取り除くアルゴリズムを活用することが必要だ。

次に、セキュリティとプライバシーの問題が顕在化している。LLMを使用する際には、機密情報が漏えいするリスクに備え、データ保護のための暗号化技術やアクセス制御が不可欠である。さらに、利用者のプライバシーを守るためには、データの匿名化についても検討しなければならない。

また、インフラ導入コストの負荷や運用の複雑さも大きな課題として挙げられる。これを解決する策の一つとしては、スケーラビリティや拡張性を備えたクラウドベースのソリューションの利用が考えられるだろう。初期投資を抑え、柔軟にリソースを拡張できるため、ROI(Return On Investment 、投資利益率)の最適化を図れるはずだ。

偏りのある出力への対策

先述の通り、LLMは、その学習データに基づいて出力を行うため、偏りのある結果を生成することが懸念される。これに対して、どのように対策を講じればよいのか。

まず、基本的な対策となるのは学習データの多様性を確保することである。可能な限り多様でバランスの取れたデータセットを用いることで、偏りのリスクを低減することが可能である。例えば、特定の地域や文化に偏らないように、国際的なデータを収集・使用するといった方法が考えられる。

次に、出力結果を第三者によって評価・監査するプロセスを導入することが有効である。人間の評価者を複数招き、結果の公平性を確認する方法である。これにより、モデルが過度に偏っていないかを継続的にチェックすることができる。

最後に、ガバナンスフレームワークを構築することが重要である。AI倫理ガイドラインを策定し、透明性と説明責任を確保することで、ビジネスや社会全体における信頼性を向上させる。具体的には、偏りを検出するアルゴリズムを組み込み、定期的な監査を行う体制を整えるといった方法が考えられる。

偏りのある出力を防ぐこれらの対策を講じることで、LLMをより信頼性高く、社会的に受け入れられるかたちで活用していくことが可能となる。

セキュリティとプライバシー

LLMを導入する際の大きな懸念事項の1つがセキュリティとプライバシーである。例えば、企業の機密データが外部に漏れた場合、競争力を失うだけでなく、法的な問題に発展する可能性もあるだろう。

具体的な対策としては、データの暗号化やアクセス制御を強化することが挙げられる。また、モデルの学習データセットに匿名化技術を適用することで、個人情報を保護する。さらに、定期的なセキュリティ監査や脅威モデリングを行い、未然にリスクを把握し対策を講じることが求められる。

プライバシーに関しては、日本国内の企業であっても、将来的な海外展開などを見越し、EUのGDPR(General Data Protection Regulation、一般データ保護規則)や、米国・カリフォルニア州のCCPA(California Consumer Privacy Act、カリフォルニア州消費者プライバシー法)などの法規制を参照することが推奨される。こうした取り組みにより、ユーザーの信頼を維持しながら技術を活用することが可能だ。

セキュリティとプライバシーの問題は、LLMの継続的な利用において考慮すべき要素である。

LLMを理解し、新しい価値を創造しよう

LLMは非常に優れた自然言語処理技術だ。LLMへの理解を深めることは、ビジネス分野でAIを活用していく上で大いに役立つだろう。

ただし、LLMを導入する際には、偏りのある出力、セキュリティとプライバシーの確保といった課題も存在する。それらを適切に解決することで、企業は新たな価値創造に一歩踏み出すことができる。これらの技術を理解し、日々進化するAI技術を駆使して、新しい価値を創造していっていただきたい。

LLM&生成AI関連の注目ホワイトペーパー

オンプレミスで実現するLLM推論の優位性に迫る。パブリッククラウドよりコストパフォーマンスが75%向上冊子「生成AI最前線 ついに始まるLLMのビジネス活用」を無料提供! AI研究家カナコさんが解説

LLMを身の回りの業務に置き換えることは可能なのか? ビジネスとのシームレスな統合を目指すには

生成AIと大規模言語モデルは将来のビジネスにどのような影響を及ぼすのか?