日本AMDは12月11日、「Advancing AI & HPC 2024 Japan」と題したイベントを都内で開催した。

題名からすると、今年10月にAMDが開催したAdvancing AI 2024での内容(基調講演はこちらから視聴できる)を日本で改めて説明という風に思われるのだが、実際には随分カスタマイズというか、本国の内容とはまた違った内容になった。それは招待講演として理化学研究所(理研)の松岡聡氏や沖縄科学技術大学院大学(OIST)の北野宏明教授が基調講演を行ったというだけではなく、AMDの基調講演の内容もまたちょっと違っていた。そんな訳で、AMDの基調講演についてご紹介したい。

最初は日本AMD社長のJon Robottom氏(Photo01)が挨拶に立ち、簡単な財務報告を含めたAMDの現状の説明を行った(Photo02)後で、Samuel Naffziger氏(Photo03)の講演が始まった。

-

Photo02:やはりデータセンター部門の売上急増が大きなポイントであることは間違いない。その一方でXboxやPS5の生産縮小/中止に伴い、ゲーミングが大幅に売り上げ減になっているのが現状の課題ではある

-

Photo03:SVP兼Corporate Fellow兼Product Technology ArchitectのSamuel Naffziger氏。AMDが本国で開催するイベントのDeep Diveセッションではしばしば説明を担当される方で、筆者も何度もお世話になっている

最初は、AMDがAI向けにEdge InferenceからCloud Trainingまで広範なら製品ラインナップを保有しているというところから始まる訳であるが、その直後からスタートした話は、「AIによって何が実現できるか?」という話である(Photo05)。

このうち自動車に関しての話は、今年4月に発表があったSUBARUの次世代アイサイトにVersal AI Edgeのカスタム品が入るという話である(Photo06)。

もっとも説明はカスタム品が入る事よりも、それによってアイサイトに実装されているAIが、安全性を強化するという点が強調された。

2つ目の「科学とデータ分析」の例としては、CERNのハドロン衝突型加速器(LHC)でのデータ検出の際にFPGA上で動くAIを利用する事で、絞り込みを行っている事例が紹介された(Photo07)。

-

Photo07:500TB/secというデータレートもすさまじいが、確かにこうした用途だとバッチサイズが大きい(=Latencyが大きい)GPUとかでは使い物にならず、FPGAなどで処理していかないと間に合わないのは良く判る

ちなみにこの科学とデータ分析という話では、招待講演で松岡氏と北野教授がやはりもっと具体的な実例や、今後のより複雑化したサイエンス向けの使われ方について色々言及を行っていた。

同様に医療やロボティクス(Photo08)についても、すでにAIを利用して色々な取り組みがなされている事に触れたうえで、その先の話としてSovereign AIにも言及(Photo09)し、現状のAIはまだ緒に着いたばかりの状態で、まだこの先に大きな発展の余地がある事をアピールした。

その上で、ちょっと話を戻してAIと科学技術計算の分野、昔だと膨大な数の物理シミュレーションを繰り返して行っていた処理を推論モデルを使って高速化したり(Photo10)、さらに自動化並列化したり(Photo11)、より一歩進んでAIベースの研究アシスタントにまで話が及んだ(Photo12)。

-

Photo10:例えば航空機の翼の形状シミュレーションはCFDの格好のテーマであったが、こちらは精度というか解像度を上げると計算量が簡単に爆発する。そこで推論を利用して、これを高速化することで絞込までの時間を高速化できるという話

-

Photo12:この話も北野教授の講演で出て来ているが、オリジナルはANLのRick L. Stevens博士の「The Decade Ahead: Building Frontier AI Systems for Science and the Path to Zettascale」かと思われる

問題はこうしたコンピューティング能力に対する需要(Photo13)が、そのまま消費電力に転嫁されてしまっている(Photo14)ことである、とする。

効率そのものの向上も進んでいるが、それよりも計算能力の増大の伸びの方が大きい結果、全然追いつかないという話で、Zettascaleのマシンは500MWクラスの消費電力になると予測される。これを様々な技法で、100MWに抑え込もうという訳だ(Photo15)。

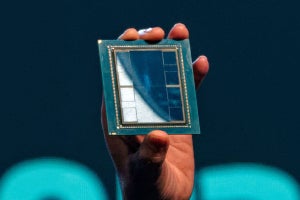

丁度11月17日から開催されたSC24に合わせ、TOP500が更新されたが、ここでAMDのCPU/GPU(Instinct)ベースのEl Capitanが1742PFlop/sを叩き出し1位、Frontierが2位に入ったが、相対的に高い電力効率を誇っている。これはこの後の話にも絡むが、El Capitanが1,742.00PFlops/29,581KWで効率は58.89GFlops/W、Frontierが1,353.00PFlops/24.607KWで54.98GFlops/Wとなっており、実はあんまり効率が変わっていない。

Green 500のトップはNVIDIAのGH200を使ったドイツのJEDIで72.733GFlops/Wを誇るのだが、実はこれが可能なのはJEDIが極めて小さなシステム=小規模なバックボーンで済んでいるからという話であって、実際JEDIの性能はたったの4.50PFlop/s、コア数は19,584個(El Capitanは11,039,616個)である。要するに大規模システムではバックボーンのネットワークにかなりの消費電力を費やす関係で、どうしてもそこがボトルネックになるのだが、これを考慮すると確かにEl Capitan/Frontierはかなり頑張っていると言っても良い。ただネットワークそのものはHPEのSlingshotを使っている関係でどうにもならない(長期的にはOptical化が考えられるとしていたが、確かに相当先の話だ)として、AMDが出来るのは自社製品の効率を引き上げることで、現在の所上手く推移しているとする(Photo17)。

ただ今後も効率化を図る必要があり、ここに向けて注力するとしている(Photo18)。

具体的には、データセンターレベルの全体最適化を図るという話で(Photo19)、今後も引き続き新技術を採用してゆく(Photo20)とする。

最後にしめくくりとして、さらに今後もイノベーションを起こすべく努力してゆくとして、氏の講演は終わった(Photo21)。

-

Photo21:光相互回路(恐らくCPO:Co-Package Optics)に言及したのもこれが最初な様な気がする。TSMCは2022年にCOUPE(COmpact Universal Photonic Engine)を発表、今年これをCPOとして提供してゆく方針を示しており、あるいはAMDもこれに乗るつもりなのかもしれない