富士通は10月22日、世界的なGPU不足に対応するため、高い実行効率が見込める処理に対してリアルタイムにGPUを割り振る独自のアダプティブGPUアロケーター技術と、各種AI処理の最適化技術を統合したミドルウェア技術「AI computing broker」(以下、ACB技術)を開発したことを発表した。

この技術はオンプレミスだけでなくクラウドで提供されているGPU環境においても利用可能で、単一のGPUを用いるAIアプリから複数のGPUを用いるLLM(Large Language Models:大規模言語モデル)まで対応するという。単一のGPUによる先行トライアルの技術検証結果を踏まえた上で、トレーダムが同技術を採用。また、さくらインターネットは富士通と共同で複数のGPUを用いて同技術の実証実験を開始する。

富士通はトレーダムとさくらインターネットに加えて、AWL、エクストリーム-D、モルゲンロットらと共に、単一GPUによるACB技術の先行トライアルを2024年5月より順次実施しており、各社のクラウド環境やサーバ上での動作を確認している。各AI処理に対する演算処理効率が最大で2.25倍向上したほか、同時に取り扱えるAI処理数の増加など有効性が確認されたという。

富士通は今後について、AI処理におけるGPUの演算効率を高めてGPUコストを削減したいAIサービス事業者や、一つのGPUにできるだけ多くのAI処理を割り当てたいクラウドサービス事業者など、GPU資源提供者を中心に同技術の提供を進めるとしている。

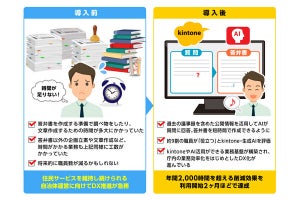

AI computing broker技術の概要

今回富士通が開発したAI computing broker技術は、アダプティブGPUアロケーター技術とAI処理を最適化する技術を統合したミドルウェア技術。複数のプログラムの中でGPUを必要とするAI処理部を分析し、計算資源の割当や最適化を自動で行う。

従来技術のジョブ単位での割当とは異なり、動的にGPU資源をGPU計算単位で割り当てて稼働率を向上させるほか、GPUメモリの管理機能によりユーザーはプログラムが使用するGPUメモリ量やGPUの物理的なメモリ容量を気にすることなく、多数のAI処理を割り付けられるようになるという。

単一のGPUを用いたACB技術の先行トライアルでは、ACB技術非適用の場合と比較して、ユーザー環境におけるGPUの単位時間当たりの処理性能が最大で2.25倍向上することを確認している。

同技術にはアプリ動作を見ながらGPUのメモリを共有する「メモリ管理機能」が備えられており、ユーザーは各ジョブの総メモリ使用量が物理メモリの最大容量に収まるかどうかを気にせずに処理を実行可能となる。これにより最大でGPUの物理メモリ容量の約5倍に相当する150ギガバイトのメモリが必要なAI処理を同時に取り扱えることを確認できたとのことだ。