Datadogは6月25日、「Data Jobs Monitoring」の一般提供を発表した。これにより、データプラットフォームチームやデータエンジニアは、データパイプラインのあらゆる場所で問題のあるOSS(オープンソースソフトウェア)の分散処理フレームワーク「Apache Spark」やDatabricksのジョブを検出し、失敗したジョブや長時間稼働しているジョブを迅速に修正することで、過剰にプロビジョニングされたコンピューティングリソースを最適化して、コストが削減できるという。

Data Jobs Monitoringの概要

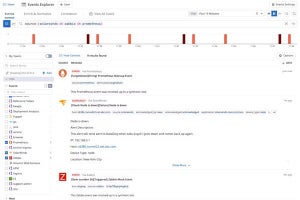

Data Jobs Monitoringは、最適化と信頼性の向上が必要な特定のジョブを即座に表示するほか、チームはジョブの実行トレースをドリルダウンできるため、ジョブのテレメトリをクラウドインフラストラクチャに関連付け、迅速にデバッグすることが可能。

また、ジョブの失敗や自動的に検出されたベースラインを越えて実行された場合、すぐにアラートがチームに通知されるため、エンドユーザーエクスペリエンスに悪影響が及ぶ前に対処できる。推奨フィルタにより、ジョブやクラスタの健全性に影響を与える最も重要な問題を特定し、優先順位を付けることができるという。

さらに、詳細なトレースビューはジョブの実行フローのどこで失敗したかを正確に表示することから、チームはトラブルシューティングを迅速に行うための完全なコンテキストを把握することが可能。複数のジョブの実行を相互に比較することで、根本原因の分析を迅速化し、実行時間、Sparkパフォーマンスのメトリクス、クラスタ使用率、および構成の傾向と変化を特定できるとしている。

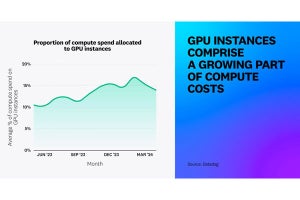

そのほか、リソース利用率とSparkアプリケーションのメトリクスにより、チームはオーバープロビジョニングされたクラスタの計算コストを削減し、非効率なジョブ実行を最適化する方法を特定することが可能だという。