米Nutanixは5月21日~23日にスペイン・バルセロナの「Fira Barcelona Gran Via」で年次カンファレンス「.NEXT 2024」を開催した。本稿では初日に行われたNutanix プレジデント兼CEOのRajiv Ramaswami(ラジブ・ラマスワミ)氏による、基調講演を紹介する。

.NEXT 2024は国内外から約4000人が参加し、今年のテーマは「Run everywhere. Let's make big things possible」。最新の技術動向や世界各国のユーザー事例、同社のビジョンや戦略などを一同に集めたカンファレンスだ。

デルと「Nutanix Cloud Platform for Dell PowerFlex」を提供

冒頭、ラマスワミ氏はここ数年における生成AIの隆盛や、昨年のBroadcomによるVMwareの買収に触れつつ「われわれはエンジニアリングの企業として存在し続け、イノベーションとカスタマーサービスにフォーカスしています。単一のプラットフォームをユーザーが環境を問わずシンプルに使えるようにし、顧客満足度を念頭に置いています」と胸を張る。

こうした状況をふまえ、同氏は「Modernize Infrastructure to a State-of-the-Art Hybrid Multicloud」「Build Modern Apps Once and Run Anywhere」「Enable Your Enterprise AI」の3つのポイントに沿って、各種の発表を行った。

まず、Modernize Infrastructure to a State-of-the-Art Hybrid Multicloudは、インフラストラクチャを最先端のハイブリッド・マルチクラウドへの最新化を意味する。ここでは、Nutanixのハイパーバイザー「AHV」の新たな導入オプションとプログラム、Dell Technologies(デル)との協業を明らかにした。

AHVの新たな導入オプションとプログラム

新たな導入オプションは、既存のハイパーバイザーからNutanixへの移行を合理的に行えるよう現在開発中の新たなAHVサーバ機能。

米Ciscoとの戦略的パートナーシップの一環として、Cisco UCSブレードサーバの認証に関してCiscoと協業しており、今回の新機能でブレードサーバを含む既存のサーバを再利用し、AHVを実行できるというものだ。

また、パートナープログラム「Elevate」の一環として、OEMパートナー各社と長期的に協業することで、既存・新規のサーバ構成を対象に、AHVの実行能力を拡大していく。

デルとの協業

一方、デルとの協業ではAHVを採用した演算用のNutanix Cloud Platformと、SDS(ソフトウェア定義型ストレージ)「Dell PowerFlex」を兼ね備えた製品として、統合型のターンキー型ハイパーコンバージドアプライアンス「Nutanix Cloud Platform for Dell PowerFlex」を提供。演算リソースとストレージリソースの独立したスケーリングが必要な企業は、リニアに拡張可能なストレージをNutanixソフトウェアにシームレスに拡大できるという。

同氏は「デルとは、当社が設立して5年後の2014年からパートナーシップを締結しています。今後、Ciscoをはじめ、当社がサポートできるハードウェアのレパートリーを広げていきます」と力を込めていた。

最新のアプリケーションにはKubernetesのテクノロジーが必要

続いては、Build Modern Apps Once and Run Anywhereだ。これは、一度構築したアプリケーションをどこでも実行を可能にするという意味。ラマスワミ氏は「組織には、AIなどの最新のテクノロジーを取り込んだアプリケーションが必要であり、それを加速する方法はKubernetesのテクノロジーを採用することです」と話す。

今夏に提供予定の「Nutanix Kubernetes Platform」

そのため、同社ではKubernetesを使用したコンテナベースアプリケーションの管理を簡素化する「Nutanix Kubernetes Platform(NKP)」を発表。NKPは、昨年買収したD2iQの大規模運用が実証済みのKubernetesプラットフォームの管理技術を基盤としており、提供開始は2024年夏を予定している。

Nutanixのデータサービスポートフォリオと連携し、スケールアウト型のブロック・オブジェクトストレージ、DBaaS(Databases-as-a-Service)を提供するほか、自動化によりKubernetesの導入、セキュリティ、監視、アップグレードといった管理を簡素化するという。

また、CNCF(Cloud Native Computing Foundation)に準拠したKubernetes上に構築されているため、ユーザーはフォークされたKubernetesバージョンや単一ベンダーのソリューションに関連する移植性、互換性、アップグレード、セキュリティの課題を低減を可能としている。クラウドネイティブなエコシステムの構成要素であるため、CNCF互換のパートナーソリューションを活用し、自社の特定のニーズに適したプラットフォームエンジニアリングのスタックを構築できるとしている。

「Project Beacon」の対象範囲を拡大

そして「アプリケーションとそのデータを基盤となるインフラストラクチャから切り離す」というビジョンにもとづき、クラウド間でのアプリケーションモビリティを実現すべく、同社が1年前にの.NEXTで発表した「Project Beacon」の進捗状況を説明した。

新規のアプリケーションを構築する開発者にとっては、信頼できるスケーラブルなインフラストラクチャ上のリソースとサービスへの迅速かつ簡単なアクセスが必要だという。

これにはブロック、ファイル、オブジェクトなどのIaaS(Infrastracuture as a Service)型データサービスと、データベース、ストリーミング、キャッシング、AI推論エンドポイントサービスといった高度なPaaS(Platform as a Service)型データサービスの両方が含まれる。

そのため、Project Beaconでは複雑な環境の運用を簡素化するツールを構築し、高性能かつWebスケールのデータソリューションを提供する。

前述のKubernetesクラスターの実行環境(EKS:AWS Elastic Kubernetes Service、GKE:Google Kubernetes Engine)で開発者が要求するKubernetes環境を一貫して導入、管理、保護、運用するためのNKPに加え、インフラストラクチャーデータサービスについてはパブリッククラウド、オンプレミスのプライベートデータセンター、エッジの環境で一貫してネイティブに管理可能なクラウドネイティブのブロック/ファイルストレージサービスを対象に、Project Beaconの提供範囲を拡大していく。

組織でのAI活用を有効にするために

最後は、エンタープライズAIを有効化するという意味を持つEnable Your Enterprise AIについてだ。

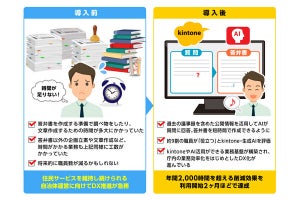

昨年9月に同社はストレージ機能とGPUをサポートし、そこにフレームワークを乗せて、すぐにAIの開発がスタートでき、AIを実行したい場所で実行可能な「Nutanix GPT-in-a-Box」を公表。今回のカンファレンスでは、新機能を含めた「Nutanix GPT-in-a-Box 2.0」を発表した。

「Nutanix GPT-in-a-Box 2.0」

GPT-in-a-Box 2.0は、NVIDIAのアクセラレーテッドコンピューティングとLLM(大規模言語モデル)のサポートを拡大し、シンプルな基盤モデル管理に対応する。具体的には、NVIDIAとHgging Faceとのパートナーシップのもと、NVIDIAの生成AIアプリケーションの開発向けマイクロサービス「NIM」、そしてHugging FaceのLLMライブラリとの連携機能を提供していく。

基盤モデル管理、APIエンドポイント作成、エンドユーザーのアクセスキー管理用の統合型のUIを採用し、Nutanix FilesやNutanix Objects、NVIDIA TensorコアGPUと連携。また、組み込みGUI、ロールベースアクセス制御、監査機能、ダークサイトのサポートなどを備えているほか、ポイントアンドクリック型のUIを採用し、本番クラスのAI開発・導入用のNVIDIA AI Enterpriseソフトウェアプラットフォームの一環として、NVIDIA NIMを導入・構成することで、企業とエッジの環境で生成AIのワークロードを容易に導入・実行できる。2024年下半期の提供開始を予定している。

AIパートナーのエコシステムを活用できるプログラム

さらに、Nutanix AIパートナープログラムも発表し、実環境向けの生成AIソリューションを提供するAIパートナーのエコシステムを活用できるようになる。パートナー各社は、Nutanix Cloud PlatformとNutanix GPT-in-a-Boxソリューションを使用し、一般的なAIユースケースを対象としたサードパーティや、自社開発の生成AIアプリケーションの構築、実行、管理、保護を支援していく。

初期パートナーはCodeium、DataRobot、DKube、Instabase、Lamini、Neural Magic、Robust Intelligence、RunAI、UbiOpsとなる。Nutanix GPT-in-a-Box 2.0は、2024年下半期中の提供開始を予定し、「NVIDIA GPUDirect」と「NX-9151」のサポートは現在、開発を進めている。

講演の締めくくりにラマスワミ氏は「最高のインフラを構築することを助け、現代のアプリケーションを構築するとともに、どこでもそれらを実行することです。そして、エンタープライズアプリケーションのためのAIを有効にしていくことで、お客さまを支援していきます」と結んだ。