NECは4月24日、LLM(Large Language Model:大規模言語モデル)「cotomi」のラインアップ拡充のため、学習データやアーキテクチャを刷新した「cotomi Pro」「cotomi Light」を開発したことを発表した。

「cotomi Pro」と「cotomi Light」

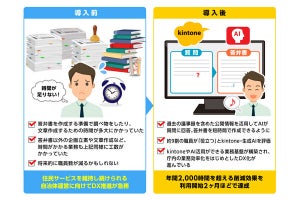

昨今の生成AIの急速な発展に伴い、さまざまな企業や公共機関が、LLMを活用した業務変革の検討・検証を進めている中で、導入・運用に際してレスポンスタイム、業務データ連携や情報漏洩・脆弱性といったセキュリティ面など、顧客ニーズにあったモデル・形態での提供が求められている。

このような背景からNECは、高速性と高性能の両立が顧客の課題解決に必須と考え、LLMのラインアップ拡充を発表した。今回開発された「cotomi Pro」「cotomi Light」は、海外ベンダーのLLMと同等の高い性能を、十数倍の速度で実現する高速・高性能なモデル。

一般的に、LLMの性能を高めるためにはモデルを大規模にする必要があるため動作速度が遅くなるが、同社は学習方式やアーキテクチャの工夫をすることで、速度と性能の両立に成功したという。

また、同社グループは約4万人の社員が生成AIの社内サービスを約1年間業務に活用しており、これら社内サービスから得られた膨大な対話履歴の解析・活用によって、現実的なユースケースでの性能も向上させている。

cotomi Proでは、GPT-4やClaude 2などグローバルのモデルと同等の性能を、GPU2枚の現実的なインフラでGPT-4の約8分の1のレスポンスタイムで実現する。

また、さらに高速なcotomi Lightでは、GPT-3.5-Turboなどと同等水準の性能を持ちながら、GPU1〜2枚程度の現実的なインフラで大量のリクエストを高速に処理することができる。

具体的には、RAGと呼ばれる仕組みによる社内文書検索システムにおいて、ファインチューニングをしていない状態でGPT-3.5以上の正答率、ファイチューニング後はGPT-4を超える正答率を、約15分の1レスポンスタイムで実現するという。

同社は今後、パートナーとの協業を強化しながら、ラインアップ拡充したcotomiをベースに、セキュアで安全・安心な生成AIサービスの提供とともに、ビジネス現場への実装を通じて、顧客の課題解決の実現を目指していきたい考え。