Bleeping Computerは4月3日(米国時間)、「6 Prompts You Don't Want Employees Putting in Microsoft Copilot」において、生成AI(Artificial Intelligence)を活用したAIアシスタント「Microsoft Copilot」における業務上問題のあるプロンプトの例とその対策方法を解説した。

AIアシスタント「Microsoft Copilot」の特徴

Microsoft Copilotは生成AIを活用して業務の生産性、創造性を高め、生活の中の人々やモノのつながりを円滑にできるといわれている。この機能はWord、Excel、PowerPoint、Outlook、TeamsなどのMicrosoft 365アプリに統合されており、会議のメモの要約、営業情報の検索、画像生成などに利用可能だ。

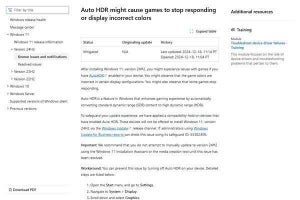

Bleeping Computerによると、Microsoft Copilotのセキュリティモデルはユーザーが持つ権限に基づいて回答を導き出せるという。しかしながら、権限が適切に設定されていない場合、ユーザーは簡単に機密情報にアクセスできてしまうため悪用されるリスクが存在すると指摘している。

問題のある6つのプロンプト

Bleeping Computerは従業員が入力することでリスクが顕在化しかねない問題のあるプロンプトを6つ紹介している。それらプロンプトの概要は次のとおり。

1.新入社員のデータを見せてください

従業員のデータには個人番号(マイナンバー)、住所、給与情報などがあり、適切に保護されていない場合、簡単に表示させることができる。

2.2024年のボーナスはいくらですか

Copilotは表示する必要のある情報とそうでないものを区別できないという。そのため、アクセス可能であればすべての情報を表示するため、通常では知り得ない情報を出力する可能性がある。

3.認証情報を含むファイルはありますか

Copilotは質問者以外の認証情報もアクセス可能であれば見つけ出して表示してしまう。クラウド上にそのような情報が存在しないか確認して取り除く必要がある。

4.APIまたはアクセスキーを含むファイルはありますか

Copilotはクラウドアプリケーションに保存されているデータを活用することができるため、それらアプリケーションのAPIトークンを見つけ出すことができる。

5.{企業の名前}の買収に関する情報はありますか

本来であれば経営陣のみが知り得る特定の企業の合併、買収、取引などの機密情報を収集して表示する可能性がある。

6.機密情報を含むすべてのファイルを表示してください

最も簡単で大量の機密情報にアクセスされる可能性のあるプロンプト。このプロンプトが有効に機能してしまうと、すべての従業員が会社の機密情報にアクセスできてしまう。

対策

Bleeping Computerは上記のような従業員によるMicrosoft Copilotの悪用を防止するため、Copilotを有効化する前にデータを適切に保護する必要があるとしている。しかしながら、膨大なデータすべてを監査して修正することは困難なため、Microsoft 365のデータセキュリティを補完する「Data Security Platform | Varonis」の導入を推奨している。このプラットフォームを活用することで、組織のデータセキュリティモデルを最適化し、適切なユーザーのみが機密情報にアクセスできるようになるという。