Micron Technologyは2月26日(米国時間)、競合のDRAMメーカーの製品と比べて消費電力を3割削減したとする24GBの「HBM3E(High Bandwidth Memory 3E)」の量産を開始したことを発表した。

この24GB 8H HBM3Eは2024年第2四半期(4〜6月期)に出荷が開始され、NVIDIAのTensor Core GPU「H200」に搭載されるという。Micronでは、自社のHBM3Eがもたらす業界をリードする性能とエネルギー効率により、AIソリューションのさらなる強化に貢献していくとしている。

AIの革命を促進するHBM3E

AIに対するさまざまな分野からの需要が増加し続ける中、そうしたワークロードの拡大に対応するメモリソリューションの存在が重要になってきており、Micronでもそうしたニーズに対応する取り組みを進めているとする。例えば、9.2Gbpsを超えるピン速度により、1.2TBpsを超すメモリ帯域幅を実現しており、超高速データアクセスニーズに対応できるとしている。

また、競合製品と比較して最大30%低い消費電力を実現しており、最小レベルの電力消費で最大のスループットを提供できるようになるとしている。

さらに、24GBへと容量を拡大させたことで、データセンターなどにおけるAIアプリケーションのシームレスな拡張が可能となるなどの恩恵を受けることができるようになるともしている。

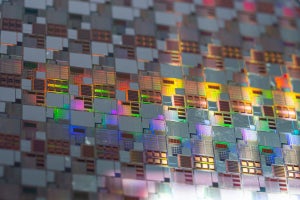

Micronによると、同製品に採用されているのは同社の1β DRAMプロセス(10nm級の第5世代DRAMプロセス)で、それにシリコン貫通ビア(TSV)技術や高度パッケージング技術などを組み合わせることで実現したという。ちなみに同社はTSMCの3DFabric Allianceのパートナーでもある。

なお、同社は2024年3月に、1.2TB/sを超すメモリ帯域幅を実現しつつ、高い電力効率を提供する36GB 12H HBM3Eのサンプル出荷を開始することも予定しており、これによりHBM分野での競争力を高めるとしている。

同社のエグゼクティブ・バイス・プレジデント兼最高ビジネス責任者のスミット・サダナ氏は今回の製品展開とNVIDIAへの採用を受けて、「Micronは、今回のHBM3Eで、市場投入までの時間のリーダーシップ、高いパフォーマンス、差別化された電力効率プロファイルという3つの要素を実現した。AIワークロードはメモリの帯域幅と容量に依存する部分が多くあるため、最先端技術となるHBM3EおよびHBM4の技術開発と、AIアプリケーションに向けた幅広いDRAMおよびNANDポートフォリオを通じて、今後のAIの成長をサポートし続けられる立場に立った」と述べている。