Malwarebytesはこのほど、「How AI hallucinations are making bug hunting harder|Malwarebytes」において、人工知能(AI: Artificial Intelligence)がバグ報奨金プログラムの厄介者になっていると伝えた。一般的にバグ報奨金プログラムは経済的利益を求める研究者・開発者と問題を未然に解決したい企業双方に有益な仕組みとされる。ところが近年、大規模言語モデル(LLM: Large Language Model)が登場したことにより、新しい問題が浮上したという。

LLMの登場により無価値なバグレポートが増加

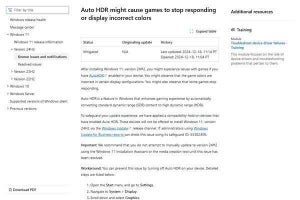

さまざまなプロトコルをサポートしたデータ転送ツールの「cURL」の開発者であるDaniel Stenberg氏はAIとバグ報奨金プログラムの問題について、ブログで「もう我慢ならない」として現状を訴えた(参考:「The I in LLM stands for intelligence | daniel.haxx.se」)。Daniel Stenberg氏によると一部の利益を求めるユーザーは数ドルの報奨金を得るために、単純な作業でバグと称するレポートを検証せずに報告してくるという。このような無価値な報告は全体の66%を占めるが、簡単かつ迅速に破棄できるためこれまで問題にはならなかった。

しかし、LLMが登場したことで状況が変化。もっともらしい無価値なレポートが送られてくるようになり、対応が必要か判断するのに時間を取られるようになったと訴えている。このような問題を解決するために、文章がLLMによって生成されたものか判別するツールが存在するが、バグの報告においては英語が得意ではない開発者によって翻訳目的で使用されることがあるため、このツールで単純に排除できないことがさらに問題を複雑にしているという。

Daniel Stenberg氏は翻訳ツールやLLMを使用した不完全な英語であっても、それが本物のバグや脆弱性の報告であれば許容できると述べている。しかしながら、LLMにcURLのソースコードを解析させ、その出力を不完全な翻訳のままセキュリティ脆弱性レポートとして送ってくる無価値な報告に強い不満を表明している。

無価値なレポートは開発者の時間を浪費させる

Malwarebytesはこのような報告は、報告者自身も問題点を理解せずに送付してくるため特に迷惑と指摘している。開発者が報告を読んで問題点を理解できない場合、報告者に具体的な説明を求めるが、報告者はこの質問に回答することができないため時間を浪費することになる。回答にLLMを使用された場合はさらに時間を無駄にする可能性がある。

将来的には、AIにより自動的にバグや脆弱性を発見できるようになる可能性がある。しかし、Malwarebytesはそのような未来のツールが開発される前に、無価値な報告を排除するツールが開発されるだろうと、検証もせずに報告するユーザーの安易な行動を非難している。