大阪大学(阪大)は9月25日、生成モデルの一種である「プロシージャルモデリング」と深層学習による画像変換技術を用いることで、現実らしい架空の景観画像を自動的に生成する手法を開発したことを発表した。

同成果は、阪大大学院 工学研究科の菊池拓哉大学院生、同・福田知弘准教授、同・矢吹信喜教授らの研究チームによるもの。詳細は、工学分野に適用するための情報工学に関する全般を扱う学術誌「Advanced Engineering Informatics」に掲載された。

都市景観のシミュレーションや分析を行うため、近年は深層学習を応用する研究が進められている。それらの研究はデータに基づく議論を可能にしているが、個別の建物にまで着目した高精細なシミュレーションや分析事例となるとあまり多くはないという。

深層学習に用いるデータセットはこれまで、人が手作業で作成する手法が主流であり、高性能な深層学習モデルを提供するためには大量の学習データが必要とされるため、多くのコストがかかることが課題となっていた。そこで近年、都市景観に関する深層学習で提案されているのが、仮想物体や3次元デジタルツインモデルと画像を組み合わせた、データセットの生成法である。しかし、これらの既存法はデータセットを自動的に生成できるが、実在する都市データを事前に用意する必要があることに加え、作成できるデータのバリエーションが有限であるという、また別の課題が生じていたのである。

そこで研究チームは今回、これらの課題を解決するために、現実的な非実在都市の3次元モデルデータを生成できるプロシージャルモデリングと現実的な画像を生成できる深層学習の画像変換技術を組み合わせた、合成データ自動生成法を開発することにしたという。

生成モデルの一種であるプロシージャルモデリングとは、入力されたデータから現実に存在しないそれらしい画像を生成したり、ある特徴に沿って入力されたデータを変換したりする技術のことをいう。また深層学習による画像変換技術とは、入力された画像の構図を維持したまま、異なるスタイルの画像に変換・生成する技術のことである。

今回開発された技術は、生成したい都市のパラメータを入力するだけで、学習データを生成する基になる3次元都市モデルが生成され、そのモデルを基に大量の学習データが生成されるという仕組みだ。生成された大量の学習データを用いて深層学習モデルを学習させ、実世界の画像から対象物を検出することを目標としているという。

-

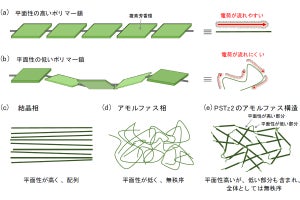

今回の手法法の概要。プロシージャルモデリングを用いて現実らしい架空の3次元都市モデルを自動生成し、ゲームエンジンと画像変換技術を用いて、3次元都市モデルから現実らしい架空の都市画像とアノテーションデータが自動生成される(出所:阪大Webサイト)

作業の進め方としては、まずStep1では、3次元都市モデルを自動生成するために都市の特徴を定めるパラメータを入力。Step2では、Step1で生成された3次元都市モデルと画像サイズなどの設定を入力し、ゲームエンジン上でアノテーションデータと景観画像データを生成するために必要なセグメンテーション画像のペアの生成が行われる。Step3では、画像変換技術を用いてStep2で生成されたセグメンテーション画像を現実らしい学習用画像に変換する。そして、Step4でアノテーションデータと学習用画像を関連付けるという流れだ。なおアノテーションデータとは、学習画像中にどんな物体がどの位置に存在しているかが示されたデータのことである。深層学習モデルはこのデータを参照して学習を行う。

-

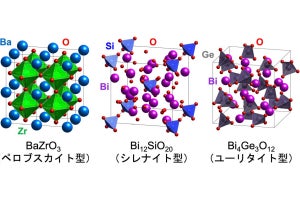

開発されたフレームワークを用いた際に、各ステップで生成されるデータ。(左)今回の研究で使用されたパラメータ項目とその設定値の例。(右)設定されたパラメータを基に生成されたデータの一例(出所:阪大Webサイト)

次に、今回の研究で開発された手法を用いて生成された合成データセットを準備し、それを学習したインスタンスセグメンテーションモデルを用いて建物の個別検出が行われた。その結果により、今回の手法で生成されたデータセットを用いて学習したインスタンスセグメンテーションモデルは、手作業により現実世界の画像で作成したデータセットで学習したモデルと同程度、もしくは、より優れた検出結果を得られたことが確認された。なおインスタンスセグメンテーションモデルとは、画像内に含まれる物体を個別に検出し、ピクセル単位で塗りつぶして、種類を判別する深層学習モデルのことである。

-

今回の手法で生成されたデータセットを用いて学習したモデル(2行目)と、現実画像を用いて学習したモデル(3行目)の検出精度の比較。現実画像で学習したモデルと同程度、もしくはより優れた結果を得ることが可能であることが示された。赤破線は現実画像で学習したモデルより優れた結果を得られた領域(出所:阪大Webサイト)

AIの精度が向上するにつれて、学習に用いられるデータセットの規模も大きくなる傾向がある。しかし、データセットの規模が大きくなるにつれて、データセットを作成するために必要とされる労働力や時間などのコストが増加し、学習に用いるデータの不足が想定されている。今回の研究成果は、データセットの準備コストを大幅に削減できることを示すとともに、都市景観のような複雑な構成の画像を対象とする場合でも、合成データを用いることが可能であることも示唆しているとした。そのため、今回の研究成果は都市景観を対象とした複雑なシミュレーションや分析を可能にするだけでなく、AIの活用が検討されているほかの分野においても新たな選択肢を提示しているとしている。