SambaNova Systemsは9月19日(米国時間)、大規模言語モデル(Large Language Models:LLM)での学習と推論の高効率化を実現するAI半導体の新製品「SN40L」を発表した。

-

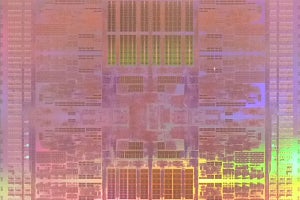

SambaNovaの最新AI半導体「SN40L」の実チップを手に、製品の特徴を説明する同社Senior Vice President, ProductsのMarshall Choy氏。同氏は米国に居り、オンラインでの説明となった

同製品は、統合されたスタックにてシングルシステムノードで25万超のシークエンス長で、最大5兆個のパラメータを扱うことを可能としたもの。競合他社を含めた従来のAI半導体と比べ、より高速に推論と学習を行うことで、高品質なモデルをより低い総所有コストで実現することを可能とするという。

TSMCの5nmプロセスを採用したほか、新たなアーキテクチャ「Cerulean(セルリアン)」を採用することで、1,026億トランジスタ、1,040個のRDU(Reconfigurable Dataflow Unit)コア、525MBのRDU統合型のオンチップメモリ(SRAM)、チップレットとして64GBのHBM3を搭載。これらによりbfloat16(BF16)で638TFlopsの演算性能を実現したとしている。また、外付けで1.5TBのDDR5 DRAMも搭載した3層データフローメモリ構成を採用することで、AIアルゴリズムが対応するタスクに対してオンチップメモリ、HBM、DDRの中から最適なものを選択することを可能としている。

-

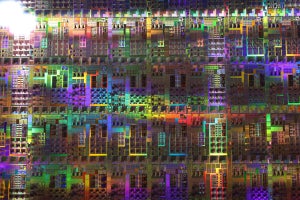

左が従来型のGPUをベースとした手法。右がSambaNovaの再定義可能なデータフローアーキテクチャ。FPGAライクな構造をしており、用途ごとにPCU(Pattern Compute Unit。再定義可能なSIMD演算器)やPMU(Pattern Memory Unit。オンチップメモリ)の最適な接続をすることで、ニーズに応じた高性能演算を実現する。最新世代のアーキテクチャとなる「Cerulean」も基本的な部分は変更はないとのこと (資料提供:SambaNova)

さらに、2023年3月に発表したas a Service型の生成AIプラットフォーム「SambaNova Suite」の新たなモデルと機能も追加。具体的には、Llama2 70億パラメータモデルおよび700億パラメータモデル、BLOOM 1,760億パラメータモデル、ベクトルベースの検索補完生成(RAG)のための新しい埋め込みモデル、音声データの書き起こしおよび分析する世界最先端の自動音声認識モデル、マルチモーダルおよび長いシーケンス長の機能の追加などが追加されたという。顧客環境としてはオンプレミスでもクラウドでも対応可能で、クラウド環境はすでに提供開始済み、オンプレミス環境の出荷は11月以降を予定。いずれの利用料金も月額性のサブスクリプションモデルでの提供となる。

このSN40Lは1ユニット(x86 CPU×2に8個のSN40L)単位で提供され、オンプレミスでは19インチラックに搭載される形で提供される。

ちなみに前世代製品は「SN30」であったが、今回の製品は「SN40L」と後ろに「L」が付いている。この点について同社のSenior Vice President, Products(製品担当上級副社長)のMarshall Choy(マーシャル チョイ)氏に確認したところ、「SNはSambaNovaの略で、40はバージョン4.0を意味する。そしてLはLanguageの頭文字で、LLMに対応したという意味」とのことで、2024年にはLLM向けではなく、汎用利用が可能なLなしの「SN40」が統合システム「DataScale」に対応させた形で登場する見通しであるとしている。

なお、日本でも生成AI市場の盛り上がりを受け、同社のソリューションにも注目が集まっているとのことで、「そうした取り組みを推進したい企業などを中心に事業の拡大を図っていきたいと」同社GM APAC(アジア太平洋地域ゼネラルマネージャー)の鯨岡俊則氏は日本市場での事業展開を見据えているほか、将来的には「大規模画像処理にも我々のソリューションは向いている。日本はマルチモーダルなモデルを見据えた顧客も多いので、そういった分野も注力していきたい。日本のみならず、韓国やシンガポールにも注力して事業拡大を図っていきたい」と展望を語っており、今後、自社製品が他社製品と比べて何がどの程度有利なのかといった情報を順次公開していきたいとしている。