横浜市立大学(横市大)は7月28日、画像から説明文を生成する「画像説明(キャプショニング)AI」の振る舞いを明らかにするため、説明文(キャプション)のみを用いて画像を認識する実験を行い、詳細な説明文が得られれば、標準的な画像認識システムと同等かそれ以上に正確な画像認識が可能であることを実証したと発表した。

同成果は、横市大 データサイエンス学部の有働帆乃璃大学院生(研究当時)、同・越仲孝文教授らの研究チームによるもの。詳細は、「第37回人工知能学会全国大会(JSAI2023)論文集」に掲載された。

近年急速に進歩しているAI技術において、特に注目されているのが、画像と言語を理解して両者の橋渡し役となるAI技術だ。自然な言葉で説明した内容から画像を生成するAIや、逆に画像からその説明文を生成する画像説明AIなどの技術が大きく進展している。しかし、画像生成AIはその過程が理解できないブラックボックス化の問題を解決できておらず、その振る舞いを理解して安心・安全を担保することを目指す取り組みが求められている。

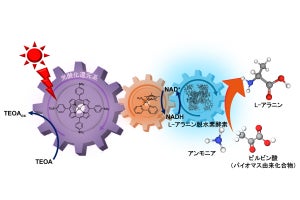

画像説明AIの振る舞いを完全に理解するためには、それが画像内のどのような情報に着目しているのか、あるいは着目していないのかを明らかにする必要があるという。今回の研究ではその1つの試みとして、画像の説明文を用いて画像認識を行うという課題を設定したとする。つまり、画像説明AIで生成した説明文をまた別のAIである言語理解AIに提示し、画像の内容を推論させるというものだ。これを標準的な画像認識システムと比較することで、説明文が原画像の情報をどの程度保持できているのか知ることができるとする。

-

(上)標準的な画像認識システムは、物体の色や形状から画像を認識する。(下)今回開発されたシステムでは、画像説明AIの説明を聞いた言語理解AIが、画像を見ずにその内容を推論する。(出所:横市大Webサイト)

実験では、自然災害画像のコレクションである「CrisisNLPデータセット」が使用された。CrisisNLPには、画像を7種のクラス(地震・火事・洪水・ハリケーン・地滑り・その他・災害なし)に分類する課題が設定されている。いくつかの画像説明AIを試した結果、詳細な説明文を生成できる画像生成補助ツール「CLIP Interrogator」(画像生成AIに与えるプロンプトを画像から生成することが可能)がもっとも良い結果を示し、その画像認識精度は85%だったという。研究チームによると、これは標準的な画像認識システムの精度(約70%)を大きく上回る結果だという。

今回使用された標準的な画像認識システムは、深層学習モデル「MobileNetV2」を用いた標準的なもので、これよりも良いとされるシステムも存在するとのこと。それでも、画像を直接認識するよりも大幅に高い精度が画像説明文のみで達成できるという結果に対し、研究チームは驚異的だとしたうえで、画像説明AIは思いのほか多くを語るといえるとしている。

ヒトの場合、伝聞情報よりも自分の目で直接確かめた情報の方がはるかに有用で信頼できるというのが常識だが、今回の研究成果から、AIにおいては必ずしもそうではないということが明らかにされた。研究チームは今後、なぜこのようなことが起こるのかをさらに詳しく調べ、人間とAIの推論プロセスの違いを明らかにすることを次のステップとして掲げている。

また今回の成果自体は、AIの説明可能性という問題に寄与できることが考えられるとする。ディープラーニング技術に基づく通常の画像認識システムは概してブラックボックスシステムであり、画像を与えると推論結果が出力されるのみで、なぜその結果に至ったのかが見えない。対して今回の画像認識システムは画像の説明文が出力されるので、推論のプロセスが人間にも理解可能である。とはいえ、昨今の画像説明AIもディープラーニング技術の塊であり、その振る舞いはほとんどわかっていないため、本格的な研究はこれからだとしている。