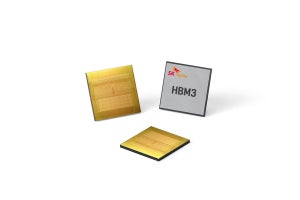

TrendForceによると、2023年の高帯域幅のメモリ(HBM)のビット数量は前年比約60%増の2億9000万GBと予測され、2024年も同30%増とさらに伸びることが予想されるという。

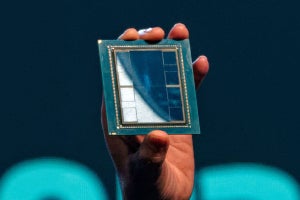

背景には、GPUにおけるDDR SDRAMの帯域幅制限に伴う転送速度の問題を解決できることなどがあり、GPUをアクセラレータとして活用するAIやHPC分野での活用が進められており、HBMを搭載したAIサーバ向けGPUも登場してきている。

TrendForceの予測では、2025年にChatGPTと同等の大規模AIGC(AI Generated Content)が5つ、Midjourney(テキストの説明文から画像を作成する独自の人工知能プログラム)の中規模AIGC製品が25つ 、小規模AIGC製品が80つと考慮すると、世界的に必要とされるコンピューティング能力の最小リソースであっても、NVIDIA A100 GPUで14万5600~23万3700個が必要となる可能性があるという。

HBMは、DDR SDRAMと比較して帯域幅が高く、エネルギー消費が低いため、HPC分野の優れたソリューションになるとTrendForceでは指摘している。例えばHBM3とDDR5を比べると、HBM3の帯域幅はDDR5の15倍ほどで、スタックされたチップを追加することでさらに拡張でき、かつGDDR SDRAMまたはDDR SDRAMの一部を置き換えることもできるため、低消費電力化を図ることもできることが強みになるとしている。

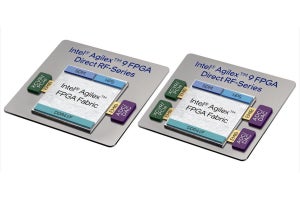

なお、HBMの現在の需要をけん引しているのはNVIDIAやAMDのAIサーバ向けGPUや、GoogleやAWSといった独自ASICを手掛ける大手CSPであるとTrendForceでは説明しており、そうしたGPUやASIC、FPGAを搭載したAIサーバの出荷台数は、2023年に同38%増の120万台近くに達すると予測され、それに伴いAIサーバ向けGPUの出荷量も併せて増加、その成長率は同50%を超す可能性があるとしている。