立教大学大学院 人工知能科学研究科は2月27日、石川真之介特任准教授、瀧雅人准教授、内山泰伸教授らと豆蔵よる研究チームが、AI(Artificial Intelligence:人工知能)の判断を「AIモデルが具体的にどのようなデータを学習したか」で説明する「説明可能AI」の手法を開発したことを発表した。この手法を用いることで、「AIの判断結果が信頼できるか」について簡便かる直感的に判断できるようになるという。

AIが精度良く判断を行うことができるかは、AIモデルの構成や学習アルゴリズムに加えて、モデルを学習させたデータの影響を受ける。近年では、AIの精度向上には複雑なモデルを利用するよりもむしろ学習データの量や質を向上させる方が重要であるとされ、AIの活用においては「データ中心」に考えるべきだとする意見もある。

これまでの説明可能AIに関する手法は、その多くが「入力データからどのように予測が導かれるのか」というAIモデルのプロセスを対象としたものであり、学習データに注目したものは少なかったという。

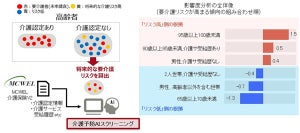

今回の研究チームは、「実際にAIモデルがどのようなデータで学習したのか」を具体例で示し、モデルの判断を説明する説明可能AIの手法を開発した。この手法は、AIの個別の判断を説明するために、対象となっているデータに対して過去に学習したデータの中で最も近いものを示す仕組みだ。つまり、AIが一番近いと判断したものを提示する。研究チームはこの手法を、AIが「私の知っていること」を提示するという意味で「What I Know (WIK)」と名付けている。

今回研究チームが発表した論文では、開発した手法を人工衛星による地球観測画像の分類問題に適用した。衛星画像に何が写っているかを、Aiが森や住宅地、川、高速道路など10種類に分類するタスクだ。

その結果、識別対象とするデータに対して、モデルが最も近いと判断したデータが非常に似ていると考えられることから、AIは十分な学習を行なっていると判断できるのだという。