企業のIT環境のアプリケーションやサービスがクラウドベースのインフラへ移行し始めてから20 年近く経ちました。多くの企業は、クラウドの高い拡張性を生かしてアプリケーションを強化し、確実に低コストで活用できることを期待して、ほとんどのコンピューティングインフラを外部委託してきました。

しかし最近では、その逆の動きもみられています。コンピューティングとサーバのインフラを外部のパブリッククラウドから自社のオンプレミスデータセンターへ再度移行している企業が増えています。

欧米ではクラウド依存からオンプレへの回帰が始まっており、その理由の多くが、クラウドにかかるコストの予測不可能な経費(クラウドコスト)の大幅な上昇です。日本国内では依然としてクラウド環境の利用を中心としたインフラ整備に向かっているように見えます。

そこでこうした状況の中、企業ではどのようにして最適なインフラを構築し、クラウドとオンプレミスを両立すべきかを事例を交えて紹介します。

進むクラウドへの移行とオンプレ回帰の両側面

IDCによると、クラウドへの移行は数年先まで継続すると予想されている一方、2021年にはサーバとストレージのインフラへの支出の半分がオンプレミスに振り向けられていると分析しています。

さらに同レポートによると、オンプレミスの支出は今後5年間で年間成長率2.9%を示し、2026年には775億ドルに達すると予測されています。さらに今後5年間でオンプレミスのサーバを少なくとも2倍導入する見込みの国内企業も出ています。

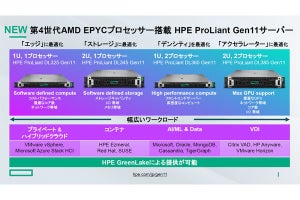

高度なエンタープライズAIやハイパフォーマンスコンピューティングのワークロードに必要なコンピューティング性能と拡張性を、企業が望むコストで実現するには、パブリッククラウドサービスだけでは不可能です。これらをクラウドで実現しようとすると、コストが大幅にアップしてしまい、オンプレミスでの展開が最適解になります。

企業のワークロード向けに最適化されたインフラを構築するためにテクノロジーを選択する際、「汎用」サーバシステムによる機能や性能では不足していることが多く、また、システムのエネルギー効率を見直す必要があります。クラウドへの移行が進む中、OPEX、CAPEXを削減するには、オンプレミスの重要性を再確認することで、事業や要件に適したインフラを構築することが必要になります。

オンプレミスのインフラとプライバシー

最も使用頻度が高い時間帯のコンピューティング要件を、中断および追加コストなく利用できるソリューションを求めている企業は少なくありません。個々の企業の要件に合わせて構築したサーバの方が、パブリッククラウドで利用されているオールインワンスタイルの汎用ハードウェアよりも、結果的に、効率的でトータルコストを抑えることが可能です。

多くの企業は、コールドストレージの用途にもクラウドを活用していますが、コンピューティングの観点からはオンプレミスでコールドストレージを実現した方が効率がよいです。また、セキュリティやプライバシーの面でも、より身近なところでデータを管理できるようになることは大きなメリットです。

企業にとって機密情報は、高度な管理が必要な最重要ポイントです。例えば、Twitterは米国内で3つのデータセンターを運用しています。これらデータセンターは数十万台のサーバと数ペタバイトのストレージを備え、多くの企業によって参照されています。これらのサーバはデータセンターの共同スペースにサーバを設置するコロケーション施設でホストされていることもあります。

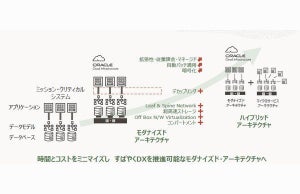

しかし、組織独自のインフラを確実に設計・管理するには、オンプレミスの運用チームがストレージの問題を特定・対処できるようにする必要がありました。自社で管理するデータセンターを導入することで、外部から直接アクセスし確実に対処をすることができ、インフラ全体のより安全な管理を実現できました。パブリッククラウドリソースを、特定のワークロードと機密性の低い用途向けのデータストレージとして機能するように設計することが可能です。

いまだにオンプレへの投資に反対する多くの組織では、長期的なコスト効率が課題をはるかに上回っていると考えています。自社内のサービスとインフラストラクチャを所有するには、サーバ展開の労力が伴うため、選択するインフラストラクチャに関係なく障壁にもなりえます。

コンポーネントの購入から管理、問題のトラブルシューティングまでを自社のエンジニアが担当することで、運用しやすくなります。例えば、AIを導入する場合は、目的に合ったワークロードのコンピューティング要件があるため、自社で構築および管理する必要があります。しかし、クラウドの汎用的なGPUコンピューティングでは、細かな調整が非常に難しく、ネットワークやストレージなどのハードウェアの詳細を分析することも困難です。

このような理由から、コンピューティングをはじめ、ストレージやネットワークインフラまで、外部に委託せず自社で管理する企業が多くなっています。

エネルギー効率の見直しによるワークロードの最適化

エネルギー効率も、データセンターの利用を見直す重要な理由の一つです。CPUやGPUの最新の世代は、前世代のテクノロジーよりも、消費電力1ワットあたりの作業量が確実に多いです。そのため、既存のワークロードをより少ない電力で処理が可能であるか、あるいは、同じ電力使用量でより多くのワークロードを同時に実行できるようになります。

例えば、旧世代のデュアルソケットシステムを、より電力効率の優れたシングルソケットシステムを備えた最新世代の製品に置き換えることが可能です。これにより、データセンターのユーザーへのサービス品質保証(SLA)を維持しながら、エネルギー使用量を大幅に減少することが可能になります。

先進的な企業では、非効率的なデンターセンターの廃止や、高密度ノードの採用、エネルギー効率の向上、ハイパースケールなどの最新設備を導入・展開することで、データセンターの総数を劇的に減らしています。

例えば、インテルは自社のデータセンターの総数を152から56に減らしています。このように非効率なデータセンターを見直す一方で、少ないエネルギーコストでワークロード容量を2倍以上に増やすことができています。

新しいデータセンターで利用しているクラスタは、ディスアグリゲート型設計により、費用対効果の高いCPUやメモリのアップグレードをより高い頻度で実現します。このアプローチはその他のコンポーネントの交換回数を最小限にとどめることができ、費用対効果の高いメンテナンスを実現できるように設計されています。そのため、電子機器廃棄物が削減され、各コンポーネンを長く有効活用することができます。

さらに、適切な自動化ソフトウェアを使用すれば、サーバやストレージシステムの管理に費やす時間を減らすこともできます。そのため、IT担当者はより多くの時間を革新やワークロードの委譲に費やし、データとコンピューティングの管理プロセスを合理化し、さらなる成長を実現することができるのです。

クラウドとオンプレミスを適材適所で利用する

こうした背景から、パブリッククラウドベースのアプリケーションやテクノロジーへの移行が進んでいる一方で、オンプレミスが再び注目を集めています。

企業はパブリッククラウドに投資する際に、組織の要件に適したテクノロジーを導入し、現在と将来予測されるランニングコストを十分に理解しておく必要があります。企業ごとにワークロードの要件は異なるため、システム全体を最適化するべきです。

パブリッククラウドを利用しつつ、オンプレミスのデータセンターに移行することで、コストを削減できるだけでなく、変化の激しい環境において柔軟性と成長性を高めることができます。

著者プロフィール

矢部 充(やべ みつる)

Supermicro テクニカルマーケティングディレクター

Digital Equipment Corporation(DEC)、OracleでのSE職を経て、Silicon Graphicsで17年間にわたり、ハイエンドグラフィックス製品、ワークステーション製品全体の製品技術統括として、防衛、航空宇宙、製造業、官公庁を中心に、シミュレーター、デザインレビュー、遠隔可視化、HPC/CAEの可視化、CAD、VR/ARなど、近年のあらゆるGPUビジネスの基礎となる市場開発に従事。約20年前にはSupermicro製汎用PCサーバに国内初となる複数枚の市販GPUカードを搭載した汎用マルチGPUサーバの構築を手がける。現在はSupermicroで市場開発と推進を担当。