基礎生物学研究所(基生研)と立命館大学は3月10日、人工知能(AI)の1つである深層ニューラルネットワーク(DNN)が300種類の動く錯視が引き起こす運動知覚を再現することを見出したこと、ならびにDNNによって本来動く知覚を引き起こさない写真や絵画から動く錯視のデザインを人工的に合成することに成功したことを発表した。

同成果は、基礎生物学研究所 神経生理学研究室の小林汰輔 特任助教と渡辺英治 准教授、立命館大学 総合心理学部の北岡明佳 教授、コードクリエイターの上坂学博士、田中健太博士の共同研究グループによるもの。詳細は学術雑誌「Scientific Reports」に掲載された。

研究グループは2018年、大脳皮質の動作原理として有力な仮説の1つである「予測符号化」を組み込んだDNNによって、動く錯視の1つである「蛇の回転錯視」の動きの錯視を再現することに成功したことを報告しているが、今回の研究は、その延長線上のものとなるという。

具体的には、錯視研究の第一人者である北岡教授が作成した299種の錯視作品と、小林特任助教が作成した1種の錯視作品を、動く錯視データベースセットとして、統一規格で用意。同データベースには、近代絵画や古典絵画、オブジェクトが動いているタイミングの写真、オブジェクトが静止している写真を各300種ずつ同梱し、合計1500種類のデータベースセットとして、先行研究で用いた学習済みDNNで解析を行ったという。

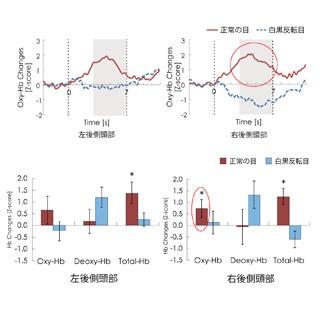

その結果、ほとんどの絵画や写真からはオプティカルフローや、それに基づく動きのベクトルは検出されなかったものの、錯視データベースからは、予測される動きの方向にベクトルが検出されたことが確認され、DNNが人間や動物同様、錯視を知覚できることが示されたほか、錯視を引き起こすメカニズムの1つとして、予測符号化が有力であることが示されたとする。

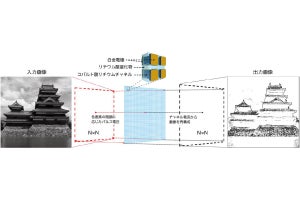

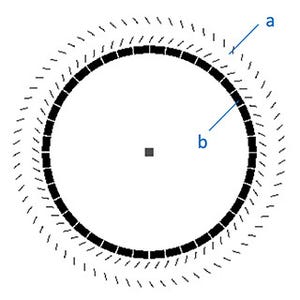

また、1個1個の画像に対してオプティカルフローの観察を行っていった結果、絵画や写真の中にも大きなベクトルを有するものがいくつか見られたことから、当該部分を切り出し、それを回転錯視のようなデザインに変更してみたところ、5人を対象者とした心理実験から、回転しているとの判定結果を得て、動くデザインとして成立していることが判明したという。例外的なフローではあるものの、そこだけ切り出すとヒトでも動いていると判断できるものを、AIが動いていない写真の中から無理やり抽出してきたこととなり、この結果は、ヒトとAIの違いを明確化するものであるとともに、一部を切り出すと錯視になるという共通点があるということも示すものであり、このデザインは、AIが発見した初めての回転錯視となると研究グループでは説明する。

-

異常なフローが検出された2枚の写真と絵画を2種類の運動ベクトル検出法(ルーカス-金出法、ファーンバック法)で部分的ながら、通常観察されない大きなフローが検出された。写真ではビル部分、絵画では柱部分 (提供:基生研/立命館大学)

-

異常なフローが検出された2枚の写真と絵画から合成された錯視2種。運動ベクトルが検出された画像の一部を切り取り、錯視様デザインを合成。いずれもヒトを対象とした心理実験から、動きが近くできることが確認されたという (提供:基生研/立命館大学)

なお、今回開発されたデータベースセットはAI研究用に公開されており、これによりAIを使った視覚研究が加速されることが期待されると研究グループでは説明している。また、DNNと心理学を組み合わせた研究から、DNNとヒトの視覚の違いが見えてきたほか、重要なのはDNNによって錯視が作成できる可能性が示されたことだとする。さらに、今回の成果は、AIであっても錯視を認識することで知覚にエラーを生じさせる可能性を示すものであり、これはAIのリスク管理という観点からも重要な知見となるとしており、すでに自動運転などで使われるAIにもこうした錯視研究が活用されており、今後、AIの特性を知るための基礎研究などが重要になってくる可能性があると指摘している。