東京大学(東大)は7月21日、超低消費電力回路実装に適した新しいスパイキングニューラルネットワークモデルを開発したと発表した。

同成果は、東大 生産技術研究所(東大生産研)の酒見悠介民間等共同研究員(研究当時、現・NEC所属)、同・森野佳生特任助教(研究当時、現・九州大学大学院 総合理工学研究院 非線形物性学研究室 准教授)、九州工業大学 大学院生命体工学研究科の森江隆教授(東大生産研 リサーチフェロー兼任)、東大の合原一幸特別教授/名誉教授(東大 国際高等研究所 ニューロインテリジェンス国際研究機構(IRCN) 副機構長兼主任研究者)らの研究チームによるもの。詳細は、IEEEのニューラルネットワークと学習システムを扱う学術誌「IEEE Transactions on Neural Networks and Learning Systems」にオンライン掲載された。

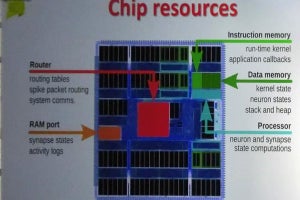

現状の深層学習(ディープラーニング)の課題は、電力を大量に消費する大規模なシステムを必要とする点で、より広く社会に役立てるためには、データをそうしたクラウドの大規模システムに送らず、エッジの小規模なシステムでリアルタイムに処理できるようになることが求められる。そのため、そのため米国や中国を中心に盛んに低消費電力な専用AIハードウェア(AIチップ)の開発が進められている。

そうしたAIチップを活用するためには、低消費電力化が可能な新しいニューラルネットワークモデルの登場が求められており、その期待されている1つが、脳の模倣度を進めた数理モデルである「スパイキングニューラルネットワーク」(SNN)を用いた学習モデルだという。

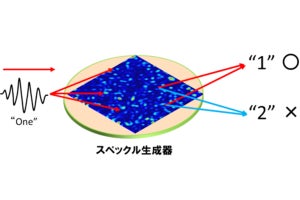

SNNは、スパイキングニューロンを構成要素とするネットワークで、スパイク(電気パルス)を受け取ることで、その重みに応じた電流が流れて膜電位が変化し、膜電位が発火しきい値を超えるとスパイクを出力するという脳のニューロンを模倣した仕組みとされており、ニューロンが非同期的に動作する特徴と、少数のスパイク信号により情報処理をする特徴を有しているため、専用AIチップで回路実装すると高い電力効率を示すと期待されている。

しかし現状のSNNモデルは、少なくとも一般的な画像認識タスクでは深層学習に認識性能が届いていないほか、SNNの特徴を活用するためには、AIチップの回路設計の難易度が高まるという課題もある。そのため、SNNを用いて低電力なシステムを構築するためには、回路実装の困難さを緩和し、同時に学習性能も向上させていく学習モデルが求められているという。

そこで研究チームは今回、高い電力効率を示すSNNの構築を目指し、専用AIチップでの実装を想定してモデルを構築するアプローチを採用することにしたという。

具体的には、「インメモリ・コンピューティング」の枠組みで回路実装できるように大胆にニューロンモデルを単純化して、多層SNNを構築することにしたという。

-

ニューロンモデル。(a)ニューロンが時刻t1、t2、t3にスパイク入力を受け、時刻t4にスパイクを出力している。(b)ある時刻までに入力を受けたスパイクの重みの合計値に従って、膜電位が一定の傾きで変化する。この特徴により回路実装が容易になるという (出所:東大 IRCN Webサイト)

さらに、構築した多層SNNが効率的な動作をするよう、ニューロンの発火時刻を使って情報処理を実行する時間符号化に基づいた学習アルゴリズムも開発。これにより、各ニューロンが最大で1回しかスパイクを出力しないようになり、高い電力効率が可能になったという。

標準的な画像認識タスクであるMNISTデータセットと、同様の画像認識タスクであるFashion-MNISTデータセットを用いて学習性能の検証が行われた結果、既存の時間符号方式のSNNより高い性能を示すことが確認されたという。

-

MNISTを学習したSNN(784-800-10)の膜電位の時間発展の様子。上図は隠れ層の膜電位、下図は出力層の膜電位が表されている。最も早く発火した出力層ニューロンのインデックスが予測値に対応している (出所:東大 IRCN Webサイト)

また、アナログ回路実装で問題となる製造ばらつきの影響も検討され、発火しきい値や発火タイミングのばらつきなどに高い耐性を示すことも示されたとするほか、インメモリ・コンピューティングの一般的な回路構成を簡略化した場合に相当するSNNモデルも構築。その学習性能の評価の結果、SNNを活用することの新たな可能性が示されたともしている。

研究チームでは、今回開発された手法について、人工知能システムを構築する際に、集積回路実装まで踏み込んで協調設計することの重要さが示された先駆的な取り組みの1つといえるとしている。また、SNNの学習アルゴリズムは近年急速に発展しており、さらにアナログ集積回路設計も大きな進展を示していることから、これらを適切に融合させた上で設計できるようになると、より高性能の次世代ニューロモルフィック人工知能システムの構築が可能になると期待されるともしている。