学術誌Natureに「Mastering Atari, Go, chess and shogi by planning with a learned model」というDeepMindのAI「MuZero」の研究報告が掲載された。ゲームのルールを教えてもらうことなく、囲碁、チェス、将棋、そしてミス・パックマンのようなAtariのゲームを習得し、知識のない環境で勝つための戦略をプランニングする。

MuZeroは、2015年の「AlphaGo」から始まったDeepMindの強化学習の第4弾として、2019年11月に論文発表された。囲碁プログラムのAlphaGoは棋譜や人との対局から学習して成長、当時世界最強とされた囲碁棋士を破って注目を集めた。続く「AlphaGo Zero」は棋譜や人との対局ではなく、AI同士の対戦を通じて急速に成長してAlphaGoを上回った。棋譜の蓄積や人との対局には時間とコストがかかる。膨大な訓練データの確保というディープラーニングの課題に対する成果になった。第3弾の「AlphaZero」は、1つのアルゴリズムで囲碁、チェス、将棋という異なるゲームをマスターした。

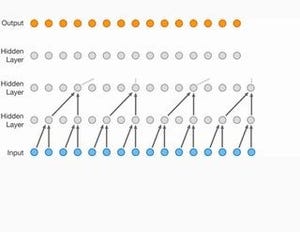

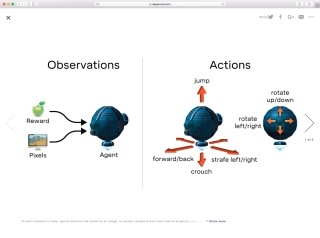

その強さと急成長ぶりが驚かれてきたが、AlphaZeroのような先読み探索を使用するシステムは、ゲームのルールや高精度なシミュレータのような環境のダイナミクスに依存し、シンプルなゲームルールの上でパフォーマンスを発揮できている。Atariのビデオゲームのように、視覚的に複雑なゲームでは環境をモデリングすることが困難であり、学習モデルが使えず、次の最善なアクションを予測するモデルフリーのアプローチを取らざるを得ない。

それは、現実の問題解決にAIを活用する上で大きな課題である。なぜなら、現実の問題はシンプルなゲームルールのようなものばかりではないからだ。人間は計画する能力によって、問題を解決に導いたり、将来のための判断を下している。暗い雲が広がり始めているのを見たら雨が降ると予測して、外出する前に傘を持っていくことを決める。人間は計画する能力をすばやく学習し、新しいシナリオに一般化することができる。

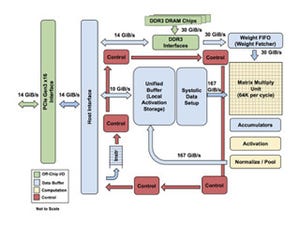

そこでDeepMindはMuZeroで異なるアプローチを採った。環境全体をモデル化しようとするのではなく、エージェントの意思決定プロセスにとって重要なアスペクトだけをモデル化する。空気中の雨粒のパターンをモデル化するより、傘を使えば濡れずにすむことを知ることの方が有用である。MuZeroはプランニングにおいて、「価値:現在の位置・状況は?」、「ポリシー:最善のアクションは?」、「報酬:最後のアクションの効果は?」の3要素をモデル化している。

MuZeroはルールを教えてもらわない状態から成長し始め、囲碁、チェス、将棋でAlphaZeroに匹敵するパフォーマンスを発揮するようになった。Atariのゲームでは、それまでのアルゴリズムを凌駕する結果を達成した。MuZeroがその学習モデルで計画を立てる能力をどのくらい役立てているのかを知るために、1手の計画に費やす時間を変化させたところ、1/10秒から50秒への増加でプレイの強さが1000Elo(プレイヤーの相対的なスキル)以上も増加した。その違いは、アマチュアの強いプレイヤーとプロの強いプレイヤーの差に相当するという。

プランニングがトレーニングを通じて利益をもたらしているか確かめるために、ミス・パックマンで、1動作あたりのプランニング・シミュレーションの回数を5回から50回までの範囲で変えたところ、プランニングの量を増やすことで、MuZeroの学習が速くなり、最終的なパフォーマンスが向上することを確認できた。しかしながら、1動作あたり6~7回のシミュレーションに制限した場合でも良好なパフォーマンスを記録しており、効果的に学習するためにすべての可能性を網羅的に探索する必要がないことを示すと見ている。

AlphaZeroはすでに化学や量子物理学などの問題に利用され始めており、MuZeroのパワフルな学習能力とプランニング・アルゴリズムのアイディアは、将来的にロボティクスや産業システム、現実において"ルールが分からない"様々な問題に取り組む道を切り開くとDeepMindは期待している。