富士通研究所とFujitsu Laboratories of America(米国富士通研究所)は10月15日、Carnegie Mellon University School of Computer Science(カーネギーメロン大学コンピューターサイエンス学部)と共同で、こまやかな表情の変化を高精度に検出可能なAI表情認識技術を開発したと発表した。

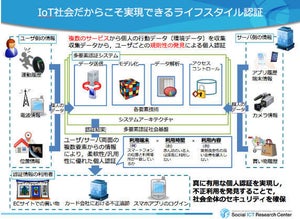

人の感情を高度に推定するには、納得や戸惑い、ストレスなど、こまやかな表情変化を捉えることが重要となり、近年ではこまやかな表情変化を扱うために解剖学的知見に基づき、顔面の各筋肉に対応した動きの単位として定義されたAction unit(AU)の活用が進み、心理学研究やアニメーションの生成など様々な分野で利用されている。

AUは、眉が下がる・頬が上がるといった顔面の各筋肉の動きに基づいて約30種に分類され、これらのAUを組み合わせることで、喜怒哀楽に加え、こまやかな表情変化も捉えることができる。

一般的にAUの検出にはディープラーニングが使われるため、ディープラーニングのための大規模な学習データの準備が必要となり、特に実際の環境ではさまざまな角度・大きさ・位置の顔がカメラで撮影されるため、それぞれに対応した大規模な学習データを準備することが難しく、結果として十分な検出精度を実現するのが困難だったという。

今回、富士通研究所と米国富士通研究所は、カーネギーメロン大学コンピューターサイエンス学部との共同研究で、AUごとに最適化された画像変換を用いて、小規模な学習データでも高精度にAUを検出するAI表情認識技術を開発。

新技術では、さまざまな角度・大きさ・位置で撮影された顔の画像に対して、顔を正面から撮影した基準の画像に見え方が近づくように、回転や拡大・縮小、平行移動などの変換処理を行う。

これにより、大規模にそれぞれの顔の角度などに対応した学習データを準備することなく、小規模な学習データでもAUを検出することを可能としている。

また、変換処理では画像における顔の複数の特徴点が基準となる正面の顔の画像における特徴点の位置に近づくように変換を行うが、特徴点を顔の部位のどこに設定するかにより、回転や拡大・縮小、平行移動の量が変化する。例えば、特徴点を目の周辺と設定して回転処理を実行すると、目の周辺は基準の顔の画像に近い位置となるが、口などの部位は基準の顔の画像とずれた位置になる。

そのため、撮影された顔の画像から、AU検出に影響の大きな領域を分析し、その領域周辺の特徴点が基準の顔の画像の特徴点の位置に近づくように、回転や拡大・縮小、平行移動の量を調整する。基準の顔の画像の見え方に近づける変換処理を、AUごとに調整することで、高精度にAUを検出する。

今後、富士通研究所と米国富士通研究所は遠隔会議支援や社員のエンゲージメント測定、ドライバーの運転の様子の見守りなど、さまざまな利用シーンでの実用化を目指す方針だ。