国内1位、世界で5位となった産総研のAIスパコン

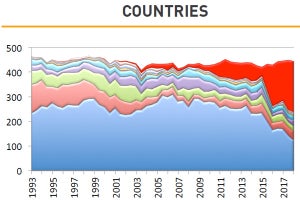

今回のTop500では、ORNLのSummitが1位となり、LLNLのSierraが3位となった。そして、中国は太湖之光が2位、アクセラレータをアップグレードした天河2Aが4位となった。これらに続く5位となったのが、産業総合技術研究所(産総研)の「AI Bridging Cloud Infrastructure(ABCI)」と呼ばれる日本のスパコンである。

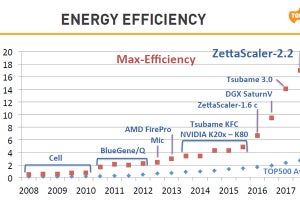

ABCIは、倍精度浮動小数点演算のピーク性能は32.577PFlopsで、その61%にあたる19.88PFlopsのHPL性能をたたき出して5位となった。ABCIはその名前が示すようにAI研究に使うスパコンであり、V100 GPUのTensorコアを使えば16bit乗算、32bit加算の混合精度演算では0.55ExaFlopsのAI/ML性能を発揮する。

なお、ABCIスパコンは、現在は試験運転中で、正式運用は8月に開始される予定になっている。

使い易いシステムを目指すABCI

ABCIの計算ノードは富士通のPRIMERGY CX400 M4サーバで、次の図に示すように、Xeon Goldを2個搭載したシャシーとV100 GPUを4個搭載したシャシーがペアで収容されている。次の写真に見えるオレンジの丸いものはCPUとGPUを冷却するAsetek製の水冷のコールドヘッドである。そして、注意してみると、CPUの両脇に実装されているDIMMの部分にも水冷のフィンが入っており、大部分の発熱を水冷で冷却できる構造となっていることが分かる。

ABCIは世界初の大型のオープンなAI研究基盤である。AIやビッグデータのアルゴリズムやソフトウェア、アプリケーションの開発を推進するためのオープンな環境を提供し、学会と産業界のAIの共同研究を促進することを目的としている。

ABCIはAI用演算では0.55ExaFlops、倍精度浮動小数点演算では37PFlopsのピーク演算性能を持つ。消費電力は2.3MWで、平均PUEは1.1以下となる見込みである。

ABCIは高密度のデータセンター設計で、消費電力を低減したウルトラグリーンな設計である。アーキテクチャ的にはデファクトのコモディティなものを使用し、ソフトウェアはコンテナ最適化を行うなど、使い易いシステムを目指している。

100以上の機関の1000人以上の研究者/エンジニアにユーザを広げることを目指しているという。

ABCIの消費電力は2.3MW

ABCIのデータセンターは、次の写真の右下の、新たに、東京大学の柏キャンパス内に建設されたものである。構造としては1階建てで、床はフリーアクセスの上げ床ではなく、ハードコンクリートの床となっている。そのため、2トン/m2の床荷重に耐えられる。

一方、上げ床ではないので、電源の供給や冷却水の供給はサーバラック上方から接続される作りになっており、天井高さは6mと、優に2階建ての高さがある。

設置したラック数は90本で、そのうち、ABCIのラックは41本である。センターの床面積には余裕を持たせてあり、最大144ラックまで増設することが可能である。ABCIの消費電力は2.3MWであるが、こちらもセンターとしては3.25MWまでの電力増に対応できるように作られている。

冷却方式には水冷/空冷のハイブリッド型を採用

ラック1本の消費電力は70kWであり、そのうちの60kWは水冷で熱を運び出し、水冷が困難な残りの10kWは空冷となっている。ABCIセンターは、3.2MWまで冷却できる設計となっている。ABCIから排出される冷却水は、風呂の湯程度の40℃であり、これをクーリングタワーで32℃に冷却している。3MW分の発熱は、クーリングタワーで冷却しており、非常にエネルギー効率が高い。どうしても低温の冷却が必要な部分のため、200kW分の冷却にはアクティブチラーを設けている。

90ラックの内、停電、瞬断対策のため18ラックにはUPSを設けるが、再スタートすれば良い計算ノードのラックにはUPSは付けていない。

-

ABCIセンターは右下の写真の新設のセンターである。144ラック分のスペースがあるが、当初は90ラックの設置である。消費電力は2.3MW。ラック1本の消費電力は70kWで、そのうちの60kWを水冷する

冷却は水冷と空冷を組み合わせたハイブリッド型となっている。次の図は冷却系を示す図である。右側の写真がサーバのコンポーネントで、32℃の冷却水を受け取り、コンポーネントを冷却した40℃の水を排出する。中央の写真はラックであり、空冷部品を35℃の空気で冷却し、40℃の空気を排出する。

上側の写真は、40℃の空気を35℃に冷却するファンコイルユニットである。ファンコイル自体は32℃の水で冷却している。

写真の左側のクーリングタワーは40℃の水を受け取り、産業用エアコンのクーリングタワーと同じ仕組みで40℃の水を32℃まで冷却する。ただし、エアコンのクーリングタワーに比べて水の温度が高いので、冷却効率は高いはずである。

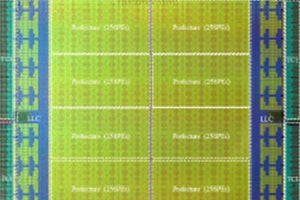

ABCIの計算ノードの構成

前述のように、ABCIのピークAI演算性能は0.55ExaFlops、ピーク倍精度浮動小数点演算性能は37.2PFlopsに達する。そして、ABCIは476TiBのメインメモリと1.6PBのNVMe SSDを搭載している。

計算ノードは2.4GHzクロック20コアのXeon Gold 6148を2個、Tesla V100 SXM2を4個、メモリを384GiB、ローカルストレージを1.6TB持っている。そして、EDRのInfiniBand×2で通信を行う。ABCIは、この計算ノードを1088ノード持っている。

また、ABCIはMulti-platform Nodeと呼ぶ、GPUをなくして、メモリを768GiB、NVMe SSDを3.8TB搭載したノードを10ノード持っている。

ABCIのストレージは22PBのGPFSで、DDNのSFA14K 3台で構成されている。

そして、これらのノード間やストレージ、ゲートウェイなどを229台の36ポートのMellanox社のSB7890 EDRスイッチと2台の648ポートのCS7500 EDRスイッチで接続している。

-

ABCIの計算ノードは2個のXeon Gold 6148 CPUと4個のTesla V100GPU、そして384GiBのメモリと1.6TBのローカルストレージで構成される。ABCIは1088計算ノードで構成され、0.55AI-EFlopsと37.2PFlopsの倍精度浮動小数点演算性能を持つ。総メモリ容量は476TiBと1.6PBのNVMe SSDを搭載する。また、ストレージとして22PBのGPFSを持っている

ABCIのソフトウェアスタックは、OSとしてはCentOSとRHEL(Red Hat Enterprise Linux)を使っている。そして、UnivaのGrid Engineでジョブスケジューリングを行う。その上に、一番ポピュラーなコンテナであるDockerと最近HPCコミュニティで認められたSingularityコンテナをサポートする。

そのコンテナで、MPIやプログラム開発ツール、ディープラーニングの各種フレームワークが使える。これらのフレームワークのコンテナイメージは、ABCIで高い性能が得られるように最適化されているという。

-

ABCIのソフトウェアスタックは、CentOS/RHELの上にUniva Grid Engineでジョブスケージュールを行い、その上にDockerとSingularityコンテナを載せる。コンテナの中では、ABCIに最適化された各種ツールやフレームワークが使用できる

次の図は、ABCIのセンター内の様子を示す写真である。センターは1階建てではあるが、内部には2階建ての建物が建っており、1階はサーバ、2階は電源や冷却という感じである。重い部品は人手では2階に運べないので、2階の部分はどのように保守するのか興味が持たれる。

アメリカと中国に水をあけられた感があるAIであるが、この施設の運用開始で、日本のAI研究、開発が加速されることを期待したい。