自動車業界で注目される音声入力

高速で走行する自動車において、さまざまな機能を操作するために音声入力機能が活用されるようになってきた。ある調査によれば、2017年の全世界での新車販売台数は9350万台。そのうちの5140万台が、何らかの音声入力機能に対応しているという。

「その5140万台のうち、4500万台に我々の技術が活用されている」。そう語るのは、音声認識技術などで知られるNuance Communicationsのプロダクト・マーケティングおよびオートモーティブ戦略部門でシニア・ディレクターを務めるEric Montague(エリック・モンタギュー)氏。Nuanceについては、音声認識・音声入力ソフト「ドラゴンスピーチ」 の開発・販売会社と言われれば、ピンとくる人も居るだろう。

そんな音声技術を長年にわたってきた同社が近年、注力している分野が自動車関連だ。特に、最近になって自動車分野は「Connected(接続)」「Autonomous driving(自動運転)」「Shared mobility & Services(シェアサービス)」「Electric powertrains(電動化)」の4つの頭文字を組み合わせた「CASE」に象徴されるような技術的、市場的な変化が激しく、自動車(OEM)メーカーも、そこにコンポーネントを提供するティア1メーカーも差別化に躍起になっている。そうした流れを受けて、同社も「単なる音声技術のサプライヤから、オートモーティブ・アシスタントのサプライヤへの変貌を目指している」(同)としており、その周辺技術の開発に余念がない。

「オートモーティブ・アシスタントは、スマートフォンに代表されるようなパーソナル・アシスタントと比べて技術何度が高い。ロードノイズのような走行音の中でも正確な聞き取りが求められるし、数十、数百と存在するコンポーネントやセンサの情報も適宜判断し、ドライバと共有する必要がある。これを実現するのが、会話型のUIであり、それをスムーズに行なうために必要なのが、会話の背景を理解して、意味を理解するといった人工知能的な機能。我々は、そうした自動車向けの音声認識や声紋認識、音声合成などのフレームワークと、それらに柔軟性を持たせるためのAI技術などを、従来より提供してきた車載向けソリューションDragon Driveにプラットフォームとして組み込んだ『Dragon Drive Innovation Showcase(DD-ISC)』を開発。OEMやティア1に、音声を活用することで、こんなことができる、といったことを紹介する活動を開始した」(同)とのことで、音声を新たなUIとして活用することをこれまで以上に自動車業界に働きかけていることを強調する。

視線と音声で自動運転時代の新たな価値を創出

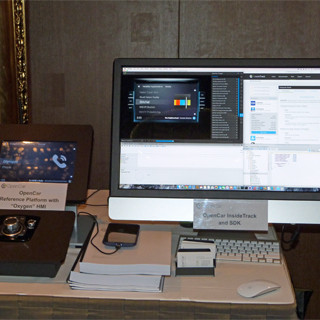

では、どのような技術がDD-ISCではデモとして体験できるのか。その最大のポイントは「Multi-Modality」だろう。これは、音声対話と視線検知を組み合わせることで、(自動運転時代になると、運転をしないため、ドライバーではなくなるため)乗客が見た外の建物の情報などを自動車側が把握、「あの店は何か?」といった問いに、地図情報を元に、何の店かを教える、といったことを可能とするもの。この視線検知技術は、同社も出資する独人工知能研究センター(DFK)が開発した技術であり、「視線と音声を組み合わせる技術は、他社にはないNuance独自のもの」という。

-

デモ車両における「Multi-Modality」のデモ。緑の四角のマーカーが視線が向いている先。ここを見たときに、音声入力で、何の店か、と訪ねると、地図情報からその店の名前を検索して提示してくれる(より詳細な開店時間などについては、インターネットと接続して、もってくる必要があるとのこと)

また、これまでの音声入力の延長線上にあるのが、「Just Talk」だ。従来は、iOSであればHey Siri、GoogleアシスタントであればOK Google、NuanceであればDragonといったように、なんらかのキーワードを先に言う必要(Wake-up-Word:WoW)があった。しかし、これだと、会話のテンポが悪く、かつ移動途中の場合、聞きたい建物情報が過ぎ去ってしまったあとなってに答える、といったことも多い。Just Talkは、ダイレクトに例えば運転席の乗客が、助手席の乗客に話しかけるように、自然な会話の形で受け答えを可能にするというもの。これは、マイクからの入力音声を、独自のNLU(自然言語理解)により、同乗者との会話であるのか、音声コマンドであるのかを瞬時に判断して対応するというもの。Multi-Modalityと組み合わせることで、走行中にリアルタイムで、あの建物が何か、といったことを自動車が教えてくれたりといったことが可能になる。

-

-

-

「Just Talk」の概要と、デモ車両によるデモの様子。この状態であれば、WoWを言わなくても、端末側で、話しかけられているのか、同乗者と話しているのかを自動で判断し、端末に話しかけていると判断した場合、自動的にその会話内容を理解してくれるようになる

さらに、自動運転時代になると、各座席ごとにパーソナル性が求められるようにもなる可能性がある。実際に、コンセプトモデルの段階だが、ノイズキャンセル技術を活用して、車内に居ながら、テレビ電話で会話をしていても、同乗者にその声が聞こえないようにするといったソリューションは複数の企業から提案がなされている。Nuanceの「Muti-Passenger Interaction」は、この発展系で、特定の座席だけハンズフリー通話を可能にすることはもちろん、声紋データと組み合わせて、誰が話しているか、と理解することで、その人がどの座席に座っているかと認識。その人のスペースだけ、空調の温度を変える、といった指示を受け付けることなどもできるという。

-

-

-

「Muti-Passenger Interaction」の概要と、デモ車両の端末で実際に機能がONになっている様子。デモ画像は、赤く光っている座席がノイズキャンリング機能がONの状態で会話をしており、ほかの座席の乗客は、その会話内容が聞き取りづらくなっている

このほか、現状は英語のみだが、複数の意図を1つの会話の中で理解するといった文脈理解の研究も進められている。これにより、例えば、今までであれば、ナビゲーションで目的地を入力していたのが、目的地検索での条件指定(例えば特定のガソリンスタンドのみを検索)が可能になるという。

自動車の価値が変化する自動運転時代

なお、こうした機能を実現するシステムのパフォーマンスは1GHz程度の動作周波数のArmコアならびに、データを格納する数MBのフラッシュメモリを搭載する程度のもので、対応できる、とのことで、現在提供されている各社の半導体性能を考えれば、それほどハードルの高いものではない。また、Multi-Modalityの地図情報については、現状のデモではHereの従来からのものを使っているが、実際に市販車両に搭載されるためには、視線の先に何があるのか、例えば、視線は低い建物に向いているが、実はその奥にある高いビルを見ている、といった判断や、自動運転タクシーで、「あそこ」に止めて、と言った場合の「あそこ」が具体的にどこを指しているのか、を理解するためには高精度な3次元地図を活用する必要があるとのことで、実用化については、まだまだ先となる。

Nuance Dragon Drive

また、現在、国内でも開発が進められているドライバーの感情を検知するセンサなどとの組み合わせも将来は考えられるとのことで、ドライバーがハッピーな状態であれば、音声システムもアップテンポなノリでナビゲートを行なったり、怒っている状態であれば、少しトーンを落として落ち着いた状態での会話にしたり、といったこともできるようになるかもしれないという。

日本でも、こうした技術を搭載したデモ車両を同社は用意しており、カスタマが指定した場所に持ち込んで、自社の技術をアピールするために活用していくとしている。また、そうしたデモを見た上で、そうした技術を活用したいとなった場合には、カスタマと協議をする必要があるが、PoCを構築して提供するといったことも可能だとしており、すでに日本でも興味を示すメーカーも出てきているとのことで、遠くない将来、同社のこうした技術を搭載した自動車が登場することになりそうだとしている。