San JoseのMcEneryコンベンションセンターで5月8日から11日にかけて開催されているNVIDIAの「GPU Technology Conference 2017(GTC 2017)」において同社のFounder & CEOであるJensen Huang氏は、基調講演の中で次世代フラグシップとなるVolta世代のGPU「Tesla V100」を発表した。

今年のGTCは、Volta GPUとAI一色であった。AIも昨年は、自動運転などが前面に出ていたが、今年は、自動車だけでなくAIの広がりとGPUの活躍が中心であった。

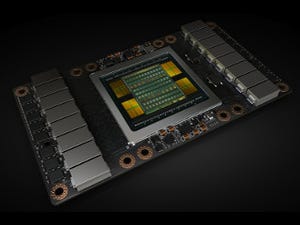

このVolta GPUチップの「GV100」コアだが、TSMCの12nm FFNプロセスで製造され、チップサイズは815mm2と露光装置の製造限界ギリギリのサイズで、21.1Bトランジスタを集積している。

|

|

|

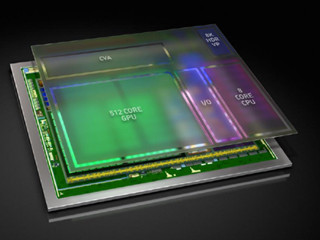

NVIDIAはTesla V100 GPUを発表。GV100は、GP100と比較してHPC性能は1.5倍、ディープラーニングの学習性能は12倍、推論性能は6倍。なお、右側のボード写真の中のGPUチップ部分は、NVIDIAお得意のグラフィックスで作ったフェイクであるので、信じないようにしていただきたい |

VoltaのSM(Streaming Multiprocessor)はFP32コアを64個、FP64コアを32個、INT32コアを64個と8個のTensorコアと4個のテクスチャユニットを持つようになった。科学技術用のフラグシップGPUであるGV100はチップ上には84SMを集積するが、4個は歩留まり向上用の予備SMで、製品としては80SMという仕様になっている。

GPUのアーキテクチャとしては、Tensorコアと呼ぶ新たな演算コアを追加した点が新しい。Tensorコアは、4×4の行列A、B、Cを入力としてD=A×B+Cを計算するユニットで、AとBはFP16、CとDはFP32、あるいはFP16とすることができる。この仕様から見て、通常の科学技術計算には使えず、ディープラーニングの向けの演算コアである。

Tensorコアは毎サイクル64積和演算ができるユニットであり、SMの中ではかなり大きな面積を占めていると考えられる。ディープラーニング向けの機能にこれだけ大きな面積を割くということを見ても、NVIDIAのディープラーニングへの入れ込みようが分かる。

L2キャッシュは全部で6MB。メモリはPascalと同じHBM2を使うが、メモリバンド幅は732GB/sから900GB/sに引き上げられている。

結果として、FP64を使う一般の科学技術計算ではGP100の1.5倍、FP32演算を使うResNet-50の学習では、V100はP100と比較して2.4倍高速で、FP16を使う推論では3.7倍高速とのことである。

NVIDIAのディープラーニング開発システムである「DGX-1」はV100搭載となり、Titan Xで8日掛かっていた処理が8時間でできるようになったという。このマシンは14万9000ドルで、今、発注すると、第3四半期に納入される予定だという。これに加えてV100を4台搭載のパーソナルDGXと称する「NVIDIA DGX STATION」も発売される。このマシンは水冷で、静かといことで、価格は6万9000ドルとしている。

なお、データセンタ向けの2CPU+8GPUの「HGX-1」も発表されたが、こちらの詳細は明らかにされていない。IBMのPOWER9 CPUが使われるのではないかと推測される。