GTC 2015では、 BaiduのチーフサイエンティストのAndrew Ng氏が3人目の基調講演を行った。中国のBaidu(百度)は日本では馴染みが薄いが、世界的にもGoogleに次いで2位の規模の大手検索サイトである。

BaiduはシリコンバレーにInstitute of Deep Learning(IDL)を作り、スタンフォード大学の現役の准教授で、AIの世界では著名なAndrew Ng氏がこの研究所を率いている。

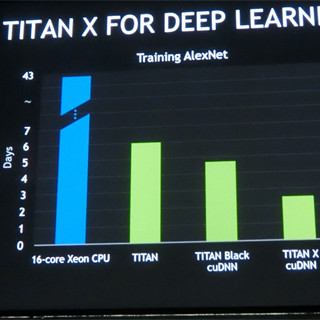

Ng氏は、Deep Learningは離陸しつつあるという。その理由は、処理がCPU→GPU→クラウド→HPCと変わって性能があがり、2007年の単一CPUでは1M接続程度のネットワークしか処理できなかったものが、多数のGPUを搭載する2015年のHPCでは100B接続と、10万倍に処理能力が上がっている。これはDeep Learningを離陸させるロケットエンジンの大型化に相当するという。

80%の精度を達成するまでの学習時間は、GPU 1基の場合は212時間掛かるが、32GPUを使えば8.6時間で終わる。この処理時間の違いは研究の進捗に大きな影響をもたらす。

機械学習は、トレーニングしても十分な精度が得られない場合は、モデルを大きくして再度トライする。そうすると学習時間も長く掛かるので、より強力なコンピュータが必要となる。これが強力なロケットが必要な理由である。そして、十分学習し、トレーニングデータはうまく認識できるモデルを使ってもテストデータをうまく認識できない場合は、トレーニングデータを追加する必要がある。これがロケットの燃料にあたり、Deep Learningの離陸には両方が必要である。

顔認識の例であるが、上の2つの写真の女性は同一人物、下の2つの写真の男性は別人である。

顔の認識に関して、Microsoftは3.67%、Facebookは1.63%、Googleは0.37%のエラー率であるが、Baiduは0.15%を達成した。これは6000人のサンプルに対して、間違ったのはわずか9人という精度である。

また、Baiduは写真へのキャプション付けも研究している。このためには、対象物の認識とは別に単語ごとの認識層を追加したモデルを使っているという。

当然であるが、Baiduでは中国語でキャプションを付ける開発も行っている。

このような画像認識は応用範囲が広く、医療画像、衣類の販売、自動運転、監視カメラ、高齢者補助、ウエアラブル(Baidu Eye)などの画像の理解とそれに基づく操作に有効と考えており、Baidu Eyeというウエアラブルの画像認識グラスを開発している。

また、Baiduはスピーチの認識にも力を入れている。スピーチ認識の場合は、時系列で音が入ってくるので、短時間の音声サンプルごとに並列に動作する認識層を設け、さらに中間のHidden層の間に左右の層と接続する経路を設けた双方向Recurrent Neural Network(BDRNN)という構造を使っている。

Baiduは実スピーチデータを7000時間、合成で作ったスピーチデータを含めると10万時間を超えるスピーチデータをもっており、これは他社より圧倒的に大量のデータである。

|

|

|

他社がせいぜい2000時間までのデータしか使っていないのに対して、BaiduのDeep Speechは実データで7000時間、合成で作成したデータを合わせると10万時間以上のデータを使って学習を行っている |

この大量のデータを使って学習を行っているので、Apple Dictation、Bing Speech、Google APIなどと比較してスピーチ認識の誤り率が低いという。

また、サードパーティーのスピーチ認識に比べてBaiduのDeep Speechは雑音に強いことをデモで示した。そして、一般の人は95%精度と99%精度の違いを理解していないが、99%精度に達すると、携帯電話などの操作を音声で行えるようになり、世界が変わるという。

また、自動車、家電(TVや電子レンジなど)、ウエアラブル機器などもスピーチインタフェースで操作できるようになる。そして、Webのサーチや広告、データセンターの管理、コンピュータのセキュリティなどもスピーチで操作できるようになるという。

画像などのデータのサーチの精度は使い勝手に直接影響するので、検索大手は認識精度で他社に負けるわけにはいかない。このため、Google、Microsoft、Baiduなどの大手は、Deep Learningに力を注いでいる。