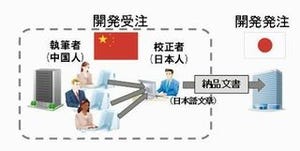

富士通研究所は4月5日、ビッグデータと呼ばれる蓄積された大量のデータ、および継続的に入ってくる新しいデータを効率よく処理することで、これらデータを分単位で活用することを可能にする並列分散データ処理技術を開発したと発表した。

同研究所が新たに開発したのは、データの読み書きの傾向に合わせてディスクのデータを動的に再配置することで、ディスクへの読み書きを従来の約1/10に削減する技術。これにより、従来、新しいデータを分析結果に反映するまでに数時間かかっていたものが数分で可能となるという。

より大量のデータから価値ある情報をよりすばやく引き出すためには、ディスクベースでかつ高速に分析結果を得られるデータ処理技術が必要だが、ディスクベースのデータ処理の方式はバッチ(一括)方式とインクリメンタル(順次)方式がある。

しかし、バッチ方式では分析対象データをいったん蓄積してから一括的に処理するため、新しい情報が分析結果に反映され活用できるようになるまでに一定の時間差が生じるという欠点があり、インクリメンタル方式では新着データをその都度順次に処理し、分析結果を直接アップデートするため、ディスクへのアクセスが多発し、分析処理全体のボトルネックとなるという問題がある。

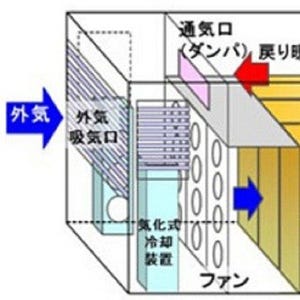

そこで、同研究所ではディスクの読み書きの回数を大幅に削減する「適応的データ局所化技術」を開発し、インクリメンタル方式の並列分散データ処理ミドルウェアを実現した。

適応的データ局所化では、まず、連続してアクセスされたデータの組を記録し、この記録に基づき、連続してアクセスされる傾向の高いデータの組をグループ化する。そして、グループに属するデータを、ディスク上の一カ所に固めて配置する。これによって、多数のランダムアクセスではなく少数の連続アクセスのみで必要なデータを取得することが可能となり、分散処理系全体のスループットが向上する。

同研究所は、この技術を電子商取引で行われるリコメンデーションのための分析処理の一部に適用したところ、従来技術に比べてディスクの読み書きの回数を約1/10に削減できることを確認したという。

今後、同研究所では、本技術のさらなる性能向上および実証実験を進め、2013年度中の実製品・サービスへの適用を目指すという。