12月7日、東京大学安田講堂にて第1回ウェブ学会シンポジウムが開催された。大学・研究機関・企業・政治やメディアなどの分野から21名が講演・討論・モデレータとして登壇し、1,000名を超える聴講者が詰めかけた。

同時に動画中継サービス「USTREAM」にて全講演がネット中継され、述べ1万人以上が視聴。会場には1,000クライアント規模の無線LANが用意され、参加者によるTwitter中継やリアルタイムの意見交換が行われたほか、登壇者への質問はTwitterでのみ受け付けるという、"学会"でありながら必要なところは可能な限りフラット化された形のシンポジウムとなった。

開会宣言に立った東京大学准教授の松尾豊氏は、ウェブはワールドワイドであるにも関わらず、日本発の情報発信が行われてこなかった現状に対し、学会のミッションを「学術とビジネス・技術の連携により世界に影響を与えるウェブ研究やウェブビジネスを生み出す場を提供する」ことであると説明。そのために、研究者、エンジニアをはじめ、経営者、投資家など様々な人が高いレベルで交流することが重要であり、「今日のシンポジウムはその第1歩」だと述べた。

また、シンポジウム終了後にはWikiサイト(暫定版)が作られ(公式ではないようだ)、USTREAMのアーカイブから登壇者の発表資料、ブログやTwitterのつぶやきまとめなど、関連する情報が続々と集められている。

各セッションの方向性や密度、リアルタイムウェブを活用した運営、またオーガナイズ面も含めて、今後のウェブ関連の研究・発表におけるひとつの基準となりえるものだったと言えるだろう。

シンポジウムの基調講演では、国立国会図書館長の長尾真氏が「ウェブ研究に求められるもの -期待と課題-」と題し、国立国会図書館のデジタルアーカイブにおけるウェブサイト収集の事例を中心に、これからのウェブ研究について語った。

「虚の世界」における国立国会図書館

国立国会図書館長 長尾真氏 |

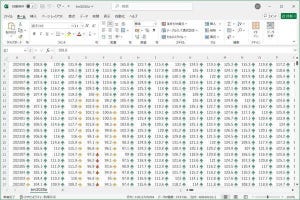

様々な場所で行われている"デジタル化"の作業により、「実の世界」である現実から「虚の世界」であるインターネット上に情報の転換が進んでいる。これまで、国立国会図書館では国内約2,500のウェブサイトに許諾を得て情報のアーカイブを進めてきたが、法律を改正し来年4月より大学・公共団体・国に関係する機関などについては許諾無しでアーカイブが可能になった。同館ではこれを図書資料と同様に公開していく考えだ。しかし、作業やコスト的な問題、また集める情報の品質などの面から全てのウェブサイトを対象とすることは難しい。

近年増えているデジタル出版物についても、一般の書籍と同じような納本義務を定め、長期保存および利用者への提供を検討したい考えだが、ここで問題になるのは何を「出版物」とするかの定義だ。長尾氏は、出版社が発行したものだけでなく、「個人がネット上で無償配布した小説なども、数十~100部以上が不特定多数に提供されていれば出版物である」と仮定義していると述べた。

このようにウェブ上の情報収集を行っていく際の課題として、刻々と変化する情報をどこまで収集できるか、差分収集をどのようなスピードで行うか、深層の情報をどこまで追跡するか、リンク先のページやデータベースをどこまで辿るかなどが挙げられた。ネット上の情報の実態把握においては、消えていくものを残す一方で、突然わき上がってきたものを確実にキャッチする技術も求められる。そのために、情報の誕生から成長・減衰・消滅までを追跡する「情報社会の生態学」の研究を積極的に行う必要があるとした。

一方、蓄積・保存したデータを活用するには情報にメタデータを持たせる必要がある。国立国会図書館ではダブリン・コア(Web上の情報を対象としたメタデータ語彙の国際標準)に沿ったメタデータを人手で付与しており、これをどこまで自動化できるかが研究課題となっている。タグ付けをせず単純な全文検索を行えば、膨大な検索結果が抽出されてしまい「結局検索していないのと同じ事」に陥る。

さらに、毎月15~20テラバイトのペースで増加しているというWeb上のデータを集め続けるのには限度がある。長尾氏は「どういう情報を集めるか、捨てるかという難しい判断を迫られるが、考えて行かなくてはならない」と、量的な問題も今後の課題であることを挙げた。

「情報」を「知識」にするために

このような巨大なアーカイブを活用するには、"検索"の性能が大きく関わってくる。トップの情報が重要だとは限らず、ロングテールの中に貴重な情報・正しい情報が存在する可能性があるが、それを探し出すには内容の階層性や正しい分類を伴う検索技術が必要となる。また、検索結果でランキングの高い情報が必ずしも信頼できるとは限らず、逆に、それと対立する内容のランキングの低い情報の方が信頼できる可能性もある。

長尾氏は、「取り出した情報を別の観点から再検索する」ことや、「信頼性を判定する付加情報をつける」「対立する情報を併せて提示する」「検索された情報の意見分布を表示する」など、利便性や信頼性向上のための工夫が必要であることを示した。

逆に、検索で見つからなかった情報については「本当にその情報がないのか疑う必要がある」という。例えばGoogleブック検索においては、日本の著作物が検索対象外であるがために、世界の全ての人にとっては求める著作物が日本に"存在しない"ことになる。「日本で独自に努力しない限り、(日本の著作物が)永久に世界から無視される危険性がある」と、衝撃ある言葉をもって"検索されない情報"の弱さを指摘した。

長尾氏は、こうした現在の検索の"欠点"をカバーするべく進められている研究事例を挙げ、検索に対してこうした言語処理プロセスを加えることで「より信頼性の高い、自分にフィットした情報を取り出せる」と説明した。

|

|

|

京都大学 黒橋研究室が開発する自然言語検索「TUBAKI」。質問の文章を解析し、同じような要素・係り受け構造を持っている検索結果を取り出す |

NICTの研究するウェブ情報分析システム「WISDOM」。分析対象に対する意見の分布形態を、男女・年代などのクラスごとに分析し視覚的に表示する |

「情報」を「知識」にするために

長尾氏は「インターネットはある意味で"電子図書館"とも見ることができ、面白い対象であるが、残念ながら信頼性に欠けている。図書館が今度どうなっていくかは微妙な問題だが、拠って立つ最後の砦は"信頼性"」と、ネット社会における図書館の意義を強調。さらに、「情報と知識は違う。ただし、情報があってこそ知識が作られる」と、情報をアーカイブした先を見据えた上で、「電子図書館はそのために今後も働いていくことになるが、我々だけで全ての知識を構築するのは不可能」として、多くの人の参加による知識の構築と信頼性の確保の重要性を訴えた。

これらのことを踏まえ、長尾氏は今後のウェブ研究において、言語処理・画像処理・人工知能・知識工学・ソフトウェア科学などの技術面だけでなく、法律・社会学・心理学など、実際の社会と同様にネット上の"虚の世界"に対しても多面的な研究を行うことが大切だと指摘。「こうした世界が安心して利用でき、創造性を発揮できる場にしていけると良い。ここにいる人たちの活躍に期待したい」と、これからのウェブ学会に対する展望を述べた。