OpenAIがGPT-4oを発表した翌日、Googleもマルチモーダルな理解能力を備えたAIエージェント「Project Astra」を公開、プロトタイプを披露した。

Google DeepMindは、前身のDeepMindの頃から「人々の日常生活に役立つユニバーサルAIエージェントを構築する」という目標を持っていた。その達成を目指して、昨年12月にリリースしたAIモデル「Gemini」を、最初からマルチモーダルAIモデルとして開発した。

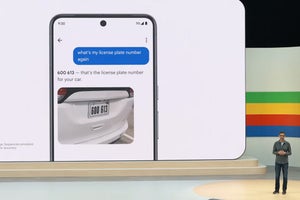

Google I/O 2024の基調講演において、Google DeepMindのデミス・ハサビス氏は「そのようなエージェントは、私たちと同じように複雑でダイナミックな世界を理解し、対応しなければなりません。コンテキストを理解し、行動を起こすためには、見たものを取り込み記憶する必要があります。そして、プロアクティブで、学習能力が高く、パーソナルなものであってこそ、ラグや遅延のない自然な会話が可能になります」と、ユニバーサルAIエージェントの構想を語った。下はGoogleがGoogle I/Oで公開したProject Astraのプロトタイプのデモ動画である。

カメラ付きのスマートフォンをかざしながらオフィスを歩き、「サウンドを出しているものを見つけて」と尋ねると、すぐに「音を鳴らしているスピーカーがあります」と返ってきた。スピーカーにカメラを向けて、スクリーン上でスピーカーの小さなコーンをマークして「これは何?」と質問すると、「ツィーターです。高周波サウンドを発生させます」と回答。窓の外にカメラを向け、「私はどこにいると思う?」と尋ねると、「ロンドンのキングス・クロス地区のようです」と答え、ホワイトボードに書かれているシステム図を見せ、その一部に矢印を書き入れて、「このシステムを高速化するには、ここに何を追加できますか?」と質問すると、「サーバーとデータベースの間にキャッシュを追加すると速度が向上する可能性があります」というアイディアを示した。

デモ動画で、AIアシスタントはユーザーと自然に会話し、質問に対して速やかに回答を提供している。スムースなインタラクションが印象的なデモであり、Googleによると、2パートから成るこのデモ動画は、各パートを1回のテイクでキャプチャした。編集のない、ありのままのデモである。デモではスマートフォンが用いられているが、今後の成長が見込まれるスマートグラスでも有望な技術である。

Project Astraは、Geminiをベースに、ビデオフレームを連続的にエンコードし、ビデオと音声入力のタイムラインを組み合わせ、それらの情報をキャッシュして効率的に呼び出すことで、AIエージェントによる高速な情報処理を実現している。

Project Astraはまだ初期段階の機能であり、正式機能とする具体的な計画は示されなかったが、Googleはその研究成果を「Gemini」アプリに取り入れて今年後半に提供しようとしている。