米Appleが同社の機械学習リサーチ・サイトで、「HUGS: Human Gaussian Splats」という、Max Planck Institute for Intelligent Systemsとの共同研究の成果を紹介している。わずか50〜100フレームの短いビデオ(24fpsのビデオなら2~4秒)から、短時間のトレーニングでシーンモデルとアニメーション可能なデジタル3Dアバターを作成できる。

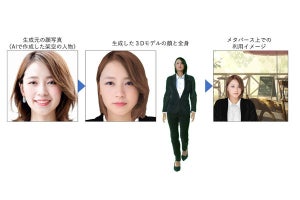

Appleが6月に発表した空間コンピュータ「Vision Pro」では、Vision Proを使ってユーザーの顔をスキャンして、「Persona」というFaceTime通話などで使える3Dアバターを作成できる。3Dアバターの作成はまだ一般的ではないが、今後この技術はデジタルコミュニケーションやソーシャルメディア、エンターテイメント、VR(仮想現実)など様々な分野で広く利用される可能性がある。HUGSは、3Dスキャン機器を使うことなく、動きのある3Dアバターの作成を可能にする。

ニューラルネットワークを使って2D画像を3Dのイメージに変えるニューラルレンダリングは、静的なフォトグラメトリー(Photogrammetry:被写体を様々なアングルから撮影した画像を解析・統合して3DCGモデルを作成)において学習時間とレンダリング速度の両方で向上が見られるが、環境内で自由に動く人にはうまく適用されていない。HUGSのモデルは動いている人が映っているトレーニングビデオから、背景やオブジェクトなど静的なものと動いている人を分離し、3Dガウシアン・スプラッティング(3DGS)を用いて、シーンモデルとアニメーション可能な人のアバターを組み合わせて動きのある表現を実現する。

人物の3DガウシアンをイニシャライズするためにSMPL(Skinned Multi-Person Linear)モデルを利用しており、線形ブレンドスキニングの重みと3DGSを組み合わせて、服や毛髪などSMPLではモデル化されないものもリアルに表現される高品質なアニメーションを生成する。

HUGSは短いビデオを用いて30分以内にトレーニングが完了し、60fpsのレンダリングが可能であるなど、NeuManやVid2Avatarといった従来の手法より大幅な高速化を達成している。人の新規ポーズの合成や、人とシーンの両方の新規ビュー合成が可能であり、下のビデオのように新規シーン内に複数の人物アバターを合成することもできる。