今年のCOMPUTEX、Intelは一切展示や講演などを行わない。2019年までは基調講演に加えてパートナー企業の展示も含む大ブースを設け、更に報道関係者向けに複数のセッションを行うのが普通だっただけに、コロナ渦で色々様相が変わったとはいえちょっとIntelの変貌ぶりには驚くばかりである。

さてそんなIntelであるが、このCOMPUTEX期間に合わせる形でMeteor Lakeの詳細を公開した。といっても、公開したのはAI機能に関する話のみである。そもそもIntelはVPUを今後のCPUに搭載する(Photo01)としており、まずRaptor LakeではM.2の拡張カードの形で搭載、Meteor LakeではCPU内部にこのVPUが入るという事が明らかになっている(Photo02)。

ここに入るVPUなるものは、もうVPUという名称からして判る通り、Intelが2016年9月に買収したMovidiusの手掛けるAIプロセッサである。同社の買収に伴い、同社が開発していたVPUはまずUSB接続のMovidius Neural Compute Stickとして発売され、その後バージョンアップした世代の製品が投入されたり、M.2対応になったりして組み込み向けに広く採用されたりしたのだが、実はIntelはこのMovidiusのVPUをチップ単体 or 拡張ユニットの形で発売するのを中止し、今後はCPU内部に搭載する形で提供する事を決めている。現在も発売されているのは第3世代のMobidius 3700Vのみであり、上位モデルの3800V/3900Vは今年3月10日に販売終了となっている。まぁそんな訳で、Meteor Lakeにはこの第3世代のVPUが搭載される訳だ(Photo03)。

何故? という回答がこちら(Photo04)。要するにAI WorkloadがどんどんClient側に移りつつあるからだ。AdobeがAIベースのソリューションを色々提供し始めているのはご存じの通りで、ただしこれらはClient上で動作するから、Client側のAI性能が必要になるとする。現状は対応するアプリケーションは少ないが、昨今のChatGPTの普及とかを見ると判るように、この先様々なアプリケーションが何らかのAI機能を統合するのは見えている(Photo05)。もっとも使い勝手の良いAI Serviceというのは必然的に要求性能が高くなるのも必須であり(Photo06)、汎用CPUとか汎用GPUで処理するのは性能的にも消費電力的にも賢いとは言えない。そこで、性能だけでなく消費電力効率の良いVPUを統合して、ここに処理をやらせることで負荷を減らそうという訳だ(Photo07)。

-

Photo05: 勿論ChatGPTはCloudベースで、Localで動かすのは色々無理があるが、逆にLocalで動く使い勝手の良いAI Serviceが開発されたらあっという間に普及するだろうというのは明白である。

-

Photo07: All SKUがCore i9/7/5/3だけなのか、Pentium/Celeron(今はIntel Processorブランドになったが)SKUまで入るのかは不明。ちなみに公式情報では無いが、このMeteor LakeからCore Ultra 9/7/5/3になるという噂がある。

このVPUは単に従来のOpenVINOだけでなく、ONNXやW3CのWeb Neural Network API、更にはDirectMLにも対応するとしており(Photo08)、現在様々な「AIを利用しているアプリケーション」への対応を進めてゆくとしている。実際VPUを使う事で、消費電力を下げながらより良い機能が実装できている、としている(Photo10)。既にAdobeが対応を表明しており、またONNXやDirectMLを利用するアプリケーションは、そのままVPUの恩恵をあずかれる、としている。

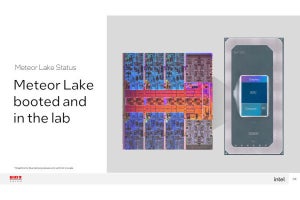

ちなみに発表はここまでで、ではそのMeteor LakeのSKUは? とかスペックは? といった話は今回は無い。今年のComputexでは動作するMeteor Lakeのプロトタイプ位は見られるか、と思っていただけにちょっと残念であった。期待して機会を待ちたいと思う。