米Googleは9月28日(現地時間)、検索とAI技術について語るイベント「Search On 2022」を開催し、今後提供する予定の検索機能を披露した。PCからモバイルへと検索の場が広がり、さらにAR/VRデバイスを用いた検索が加わってくる。そうした変化の中でユーザーが効率的に情報を見つけられるように、同社は情報探索を楽にする新たな検索体験と、カメラを用いてより自然かつ直感的に検索できる方法を今年後半に追加する。

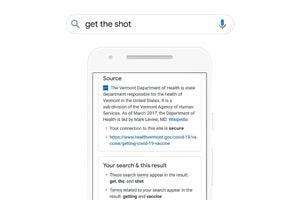

Googleが検索の進化のコアに据えているのがユーザーの検索の意図を理解すること。それによってユーザーはより少ない検索語で、目的の情報やユーザーにとって役立つ情報を効率的に得られるようになる。

新たな検索体験は、ユーザーが検索ボックスにキーワードを入力し始めると、ユーザーの検索意図を推測して、質問の作成を助ける検索キーワードやトピックの候補を提案する。例えば、家族旅行の計画で「Best mexico cities」(メキシコで最適な街)と入力し始めたユーザーに、「for families」(家族連れに)や「to vacation」(休暇に)と提案。ユーザーは「メキシコで家族連れに最適な都市」というような質問をすばやく完成させられる。

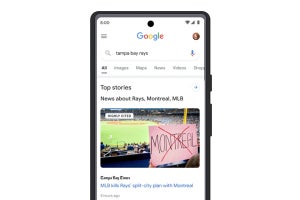

旅行先の情報を収集する検索など、結果から様々なWebページを開いてブラウザがタブだらけになることが珍しくない。新たな検索体験では、信頼できるソースからの情報、関連するイメージやショート動画などをまとめて提供してユーザーの情報探索を支援する。ユーザーが求めている情報だけではなく、トピックをより深く掘り下げたり、ユーザーにとって役立つと思われる異なる視点も示す。例えば、メキシコを旅行先として考えていても、先住民文化が残る観光地の魅力に気づいていないユーザーがいるかもしれない。そうしたユーザーにオアハカのような都市を紹介して新たな発見につなげる。

今日の検索ユーザー、特にモバイルユーザーはテキストよりも画像や動画から情報を得るのを好む。そこで結果に画像や動画をより多く表示する。それら3つの新しい情報探索の方法は、今後数カ月にわたって展開していく予定だ。

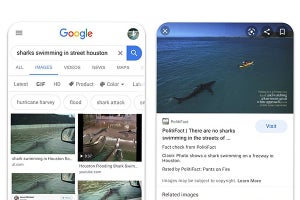

「検索ボックスにとらわれない検索」として、Googleは今年春にビジュアル検索に「マルチサーチ」を導入した。例えば、自分の持っているシャツと同じ柄のネクタイが欲しい時に、Googleレンズでシャツを撮影し、ビジュアル検索結果において「ネクタイ」という検索を追加することで検索できる。現在マルチサーチは英語のみの提供になっているが、今後数カ月のうちに70カ国以上の言語に対応させる。

また、5月に開催したGoogle I/Oでプレビューした「multisearch near me」を今秋にUS英語で展開し始める。料理や商品などの写真やスクリーンショットから、その料理や商品を提供する近くにあるレストランや店を検索できる。ローカル検索とショッピング検索などを組み合わせたマルチサーチ機能だ。

他にも、Googleレンズを使った単語や文章の翻訳の機能が年内に向上する。現在は翻訳後に翻訳したテキストがグレーのカラーブロックで囲まれて表示され、翻訳部分が多いと画像がカラーブロックで塗りつぶされてしまうが、文字だけを置き換えるように翻訳を表示する。Google Pixelの「消しゴムマジック」と同じ技術を用いており、約100ミリ秒の速さで結果を表示できるという。

iOS版の「Google」アプリのアップデートで、28日にビジュアル検索などへのショートカットが追加された。検索ボックスの下に「製品やサービスを見る(スクリーンショット内)」「テキストを翻訳(カメラを使用する)」といったショートカット・ボタンが表示され、画像、カメラやマイクを用いた検索機能にワンタップでアクセスできる。