米NVIDIAは3月23日(日本時間)、オンラインで開催の「NVIDIA GTC 2022」における基調講演を実施し、その中で新GPU「NVIDIA H100」を発表した。2022年後半からの提供を予定する。

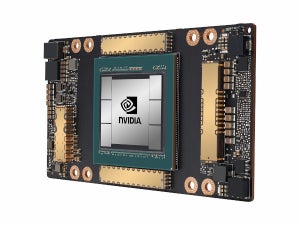

NVIDIA H100は、「NVIDIA Hopper」アーキテクチャを採用するHPC AI向け新GPU。「NVIDIA A100」の後継モデルに位置づけられており、製造にはTSMC 4Nプロセスを採用して約800億トランジスタを集積。GPUメモリには初めてHBM3を搭載し、TSMC CoWos 2.5Dパッケージング技術によって電圧制御システムごとスーパーチップモジュール「SXM」へと統合する。空冷と水冷の両方に対応しており、単体で最大700Wまでパフォーマンスを拡張するとしている。

推論方式にはFP16やTF32に加え、新しくFP8にも対応する。性能は前モデルのNVIDIA A100比で飛躍的に向上しており、FP8で6倍、FP16やTF32では3倍の向上幅を実現。仮想化機能も強化され、最大7つへのインスタンス分割や強力なI/O仮想化もサポート。各インスタンスがTEE(Trusted Execution Environment)に準拠する極めて高いセキュリティ性能も備えている。スーパーチップモジュール「SXM」版とPCIeカード型の2つが用意されており、主な仕様は下の画像の通り。

さらに、NVIDIA H100はバリエーションモデルも展開する。「NVIDIA H100 CNX」は、CX-7 SmartNICをH100と同じカード上に統合しており、CPUやDRAMを経由しない超高速ネットワークインタフェースをGPUに直結可能。「NVIDIA Grace Hopper」はCPU「NVIDIA Grace」を同一ボード上に統合しており、CPUとGPU間で900GB/sという極めて大きな帯域幅を実現する。これらを柔軟に組み合わせることで、さまざまなシステムの構築を行えるという。

-

NICを統合した「NVIDIA H100 CNX」や

-

CPUを統合した「NVIDIA Grace Hopper」も発表された

-

組み合わせは自由自在。必要なリソースを組み合わせてアプリケーションの需要に応えられる

また、このNVIDIA H100を8つにまとめた「DGX H100」や、そのDGX H100を最大32台まで相互に接続して構成する「NVIDIA NVLINK Switch System」もあわせて発表された。なお、“Hopper”や“Grace”の命名には、プログラミング言語「COBOL」を開発した米海軍の元准将/計算機科学者のGrace Murray Hopper氏から採られている。