筐体は水冷となっており、水温は18℃~25℃となっている。多分、入り口は18℃程度であるが、出口に近いところでは25℃程度まで上昇するのであろう。そして、冷却水の流量は20~30gpmとなっている。このgpmはGallon per Minutesで毎分76リットルから114リットルに相当する。京スパコンの計算ノード筐体の流量は44リットル/分であるので、BG/Qの筐体では京スパコンの2~3倍の流量となっている。もっとも、京スパコンでは1筐体のプロセサチップ数は96個であるのに対して、BG/Qでは1024個を詰め込んでいるので、冷却水の流量も多く、温度上昇も大きいのは当然である。

筐体は、ほとんどの発熱が水冷されるので、これまでの空冷のBlueGeneのように斜めに張り出した空気ダクトを付ける必要はないのであるが、従来のシステムの外観のイメージを引き継ぎ、筐体の側面には斜めの模様が描かれている。

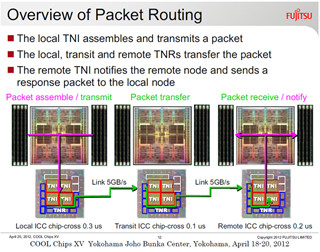

5次元トーラスの接続は、筐体内の接続はプリント配線や電気ケーブルで行い、筐体間をまたぐ接続は光ファイバが使われている。このインタコネクトを使った2つのノード間のデータ伝送の通信遅延時間は最大でも ~3μsとなっており、これは京スパコンの約半分である。また、BG/Qのインタコネクトは、京スパコンのTofuインタコネクトと同様に、BarrierやCollective通信をサポートする機能を持っており、CollectiveやBarrierの遅延時間は~6μsとなっている。これは、京のTofuインタコネクトの10μsより速い。接続を5Dトーラスとしてネットワークの半径を小さくしたことが効いているのではないかと思われる。

巨大スパコンでは、信頼度が大きな問題になる。これに関して、Chiu氏は、次のローレスバークレイ国立研究所(LBNL)のデータを示した。

ここで比較されているのは、CrayのXT3/XT4スパコン、普通のIntelやAMDのプロセサを使うサーバからなるクラスタスパコンとBG/L、BG/Pである。故障率はTFlopsあたりの月間の故障回数で比較されており、Crayのスパコンは~0.1~1となっている。これは1PFlopsのシステムであれば、月に100回から1000回の故障ということになる。そして、普通のサーバを並べたクラスタでは2.6~8.0となっており、Crayに比べるとほぼ1ケタ高い故障率である。

これに対して、BG/L、BG/Pでは0.01~0.03であり、Crayより1ケタ低く、1PFlopsのシステムでも月に10回から30回の故障ということになる。ただし、この0.01~0.03故障/月/TFlopsは前の世代のBlueGeneシステムの実績であり、20PFlopsのSequoiaシステムでは月に200回から600回の故障ということではない。コンピュートチップのFlops値がBG/Pでは13.6GFlopsであったが、BG/Qでは204.8GFlopsと15倍に引き上げられおり、TFlopsあたりの BG/Qの故障率はさらに低い値になっているはずである。

また、この表では消費電力とシステムのコストも比較しており、BG/Pは他のシステムに比べて消費電力も小さく、システムコストも安いという結果になっている。

2012年6月のTop500で「京」に代わってSequoiaがトップになるのかとChiu氏に質問してみた。4月にはSequoiaの96筐体の納入は終わるという情報もあり、半ば、「すでに納入は終わっており、トップになる可能性が高い」という自信ある回答を予想していたのであるが、答えは、「競争であり、分からない」というものであった。